前言

Chat With RTX 是一个 Demo,用来将您自己的资料(文档、笔记、视频或其他数据)与大语言模型建立连接,从而令 LLM 更具个性化。利用检索增强生成 (RAG)、TensorRT-LLM 和 RTX 加速,您可以与自定义聊天机器人对话,快速灵活地获得聊天机器人根据您的内容给出的见解。此外,由于 Chat with RTX 完全在 Windows RTX PC 或工作站本地以安全的方式运行,因此您可以更快获得更满意的结果。

https://www.nvidia.cn/ai-on-rtx/chat-with-rtx-generative-ai/

本文主要记录安装过程。后续计划使用期打造个人的知识库。

下载地址

https://www.nvidia.com/en-us/ai-on-rtx/chat-with-rtx-generative-ai/

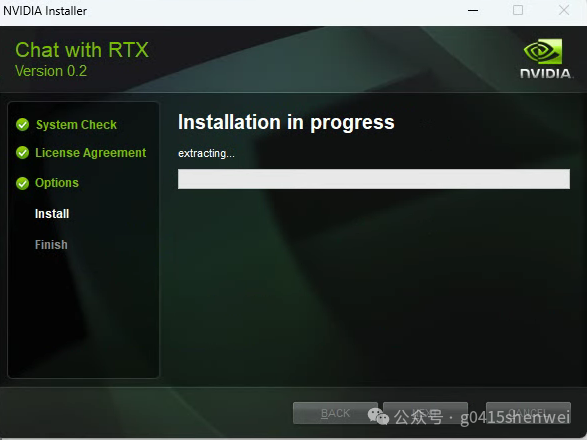

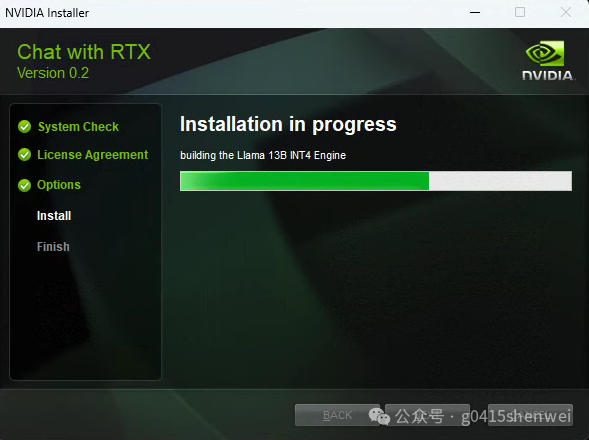

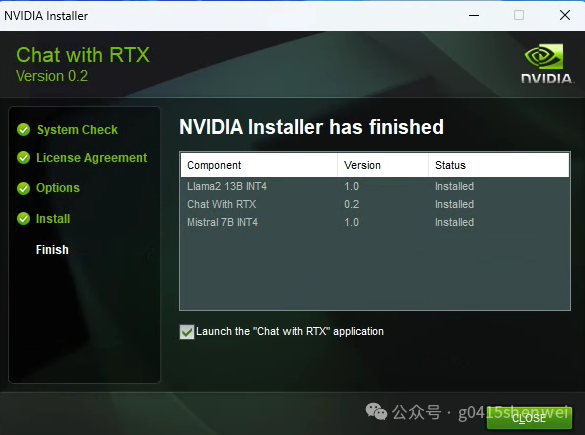

傻瓜安装

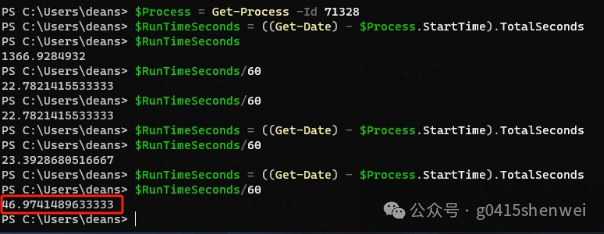

整个过程持续了46分钟

运行

直接运行桌面的快捷方式

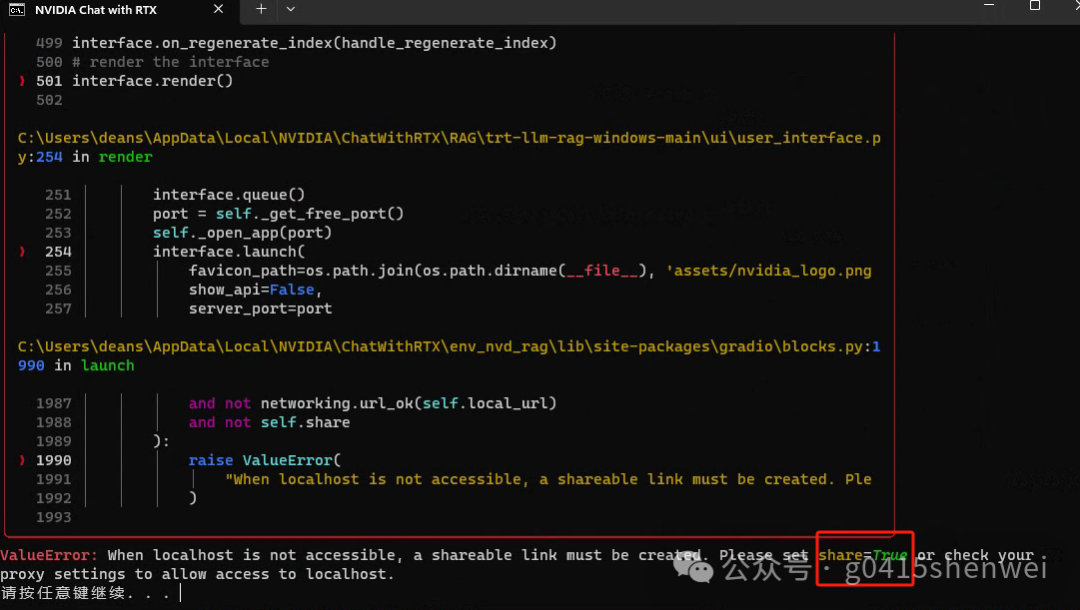

不过初次运行会报错

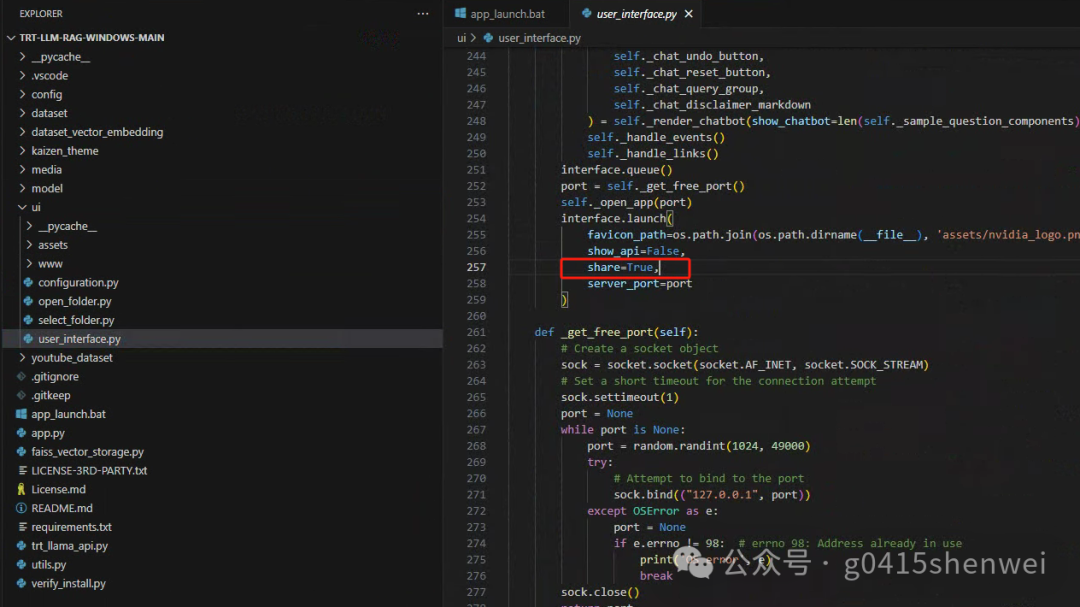

在ui\user_interface.py的257行 添加share=True 即可解决

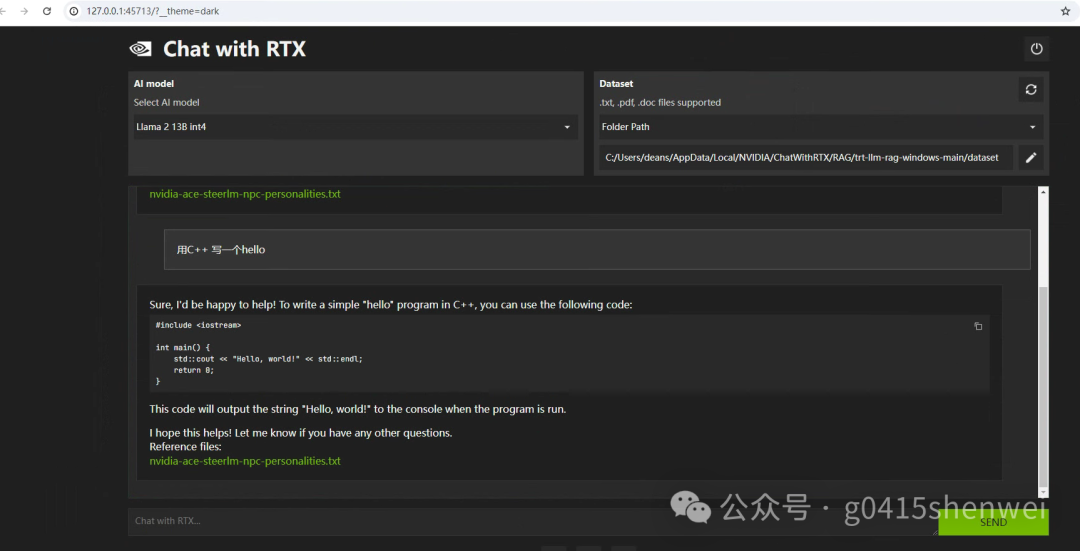

之后运行界面如下

离线运行

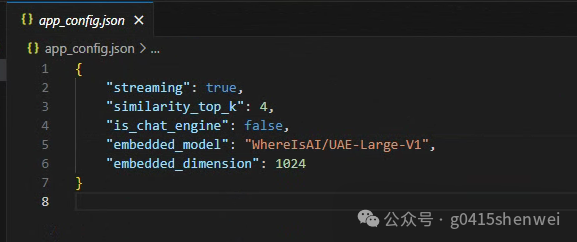

在config\app_config.json中,会记录一个内嵌模型名称

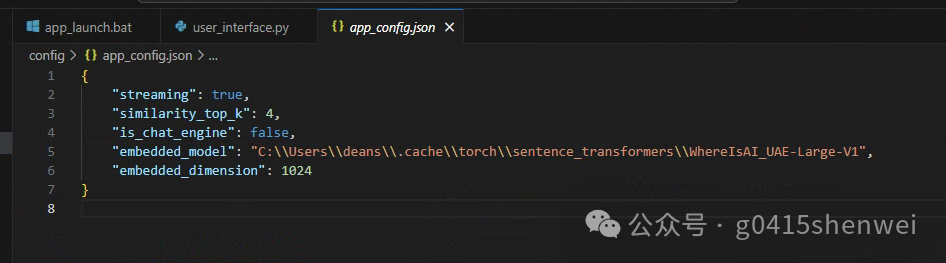

这个时候会下载模型到本地缓存 C:\Users\deans\.cache\torch\sentence_transformers\WhereIsAI_UAE-Large-V1 我们只需要把路径修改为这个路径 即可离线运行。

总结

以外惊奇,这个居然是个网页,我们可以调用其api进行自己的应用开发,后续api的使用,继续进行整理。