论文名称:

LMC: Large Model Collaboration with Cross-assessment for Training-Free Open-Set Object Recognition

论文链接:

https://readpaper.com/paper/4803888389338169345

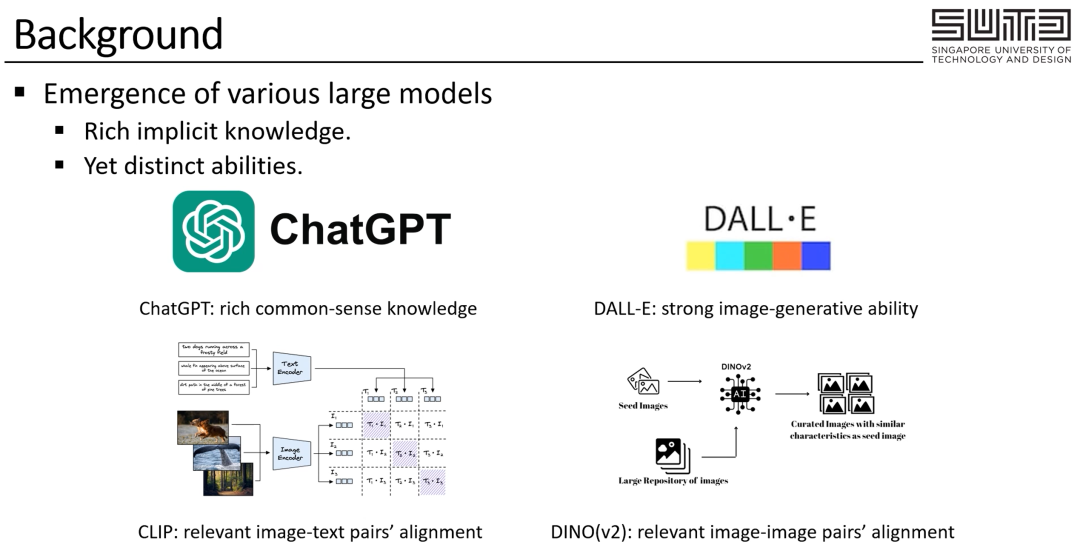

非常高兴跟大家分享我们接收于NeurIPS 2023的工作LMC:通过大模型合作与互相评估来进行无需训练的开放集识别。在这个工作中我们首先观察到,尤其从去年开始各式各样的大模型已经出现在我们的日常生活中,这些大模型往往具有丰富的知识,并具有不同的能力:比如ChatGPT具有丰富的常识;DALL-E模型可以帮助我们生成丰富的图片 ;CLIP模型可以帮我们对齐相关的图文对;而DINO模型则可以帮助我们对齐相关的图片……

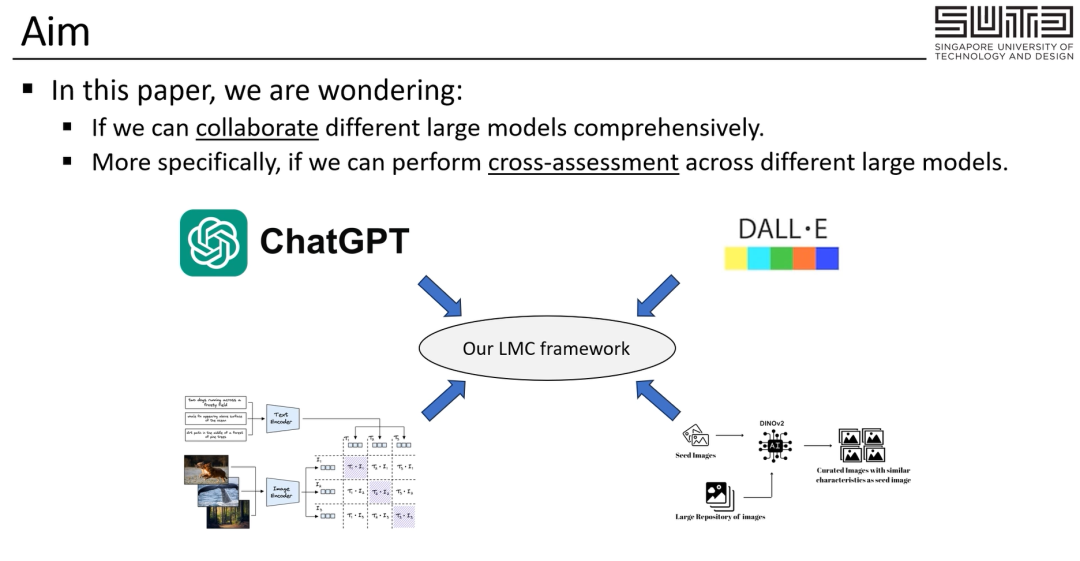

基于此在这个工作中,我们想要知道,我们可不可以让这些不同的大模型互相合作来更好地帮助我们呢?或者更细致地讲 我们可以让不同的大模型通过它们各自不同的能力来互相评估 以达成更好的效果吗?

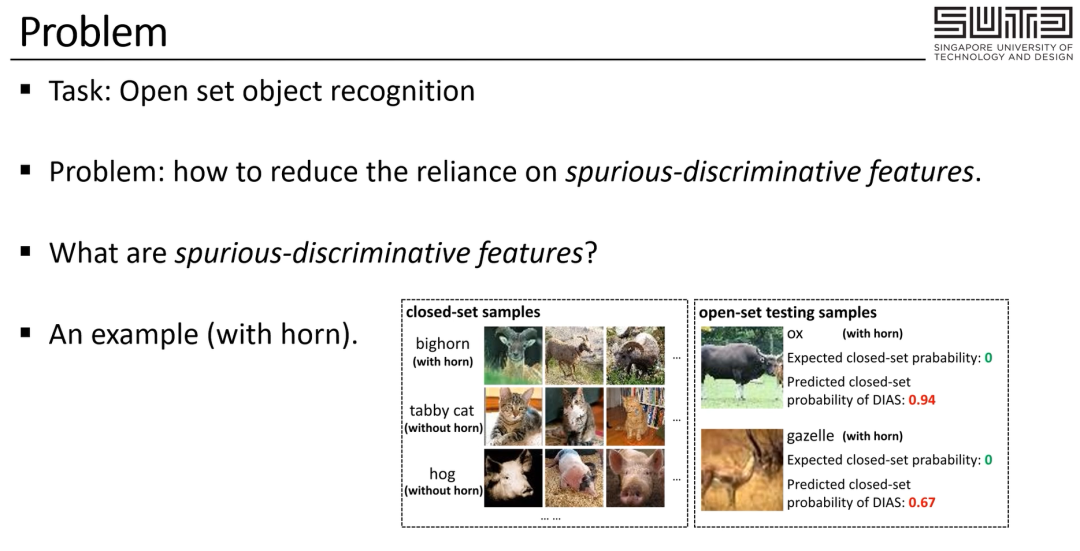

在这篇工作中,我们是以开放集识别这个任务为例,来探索大模型互相合作与评估的可能性。这个任务的定义是给定一张属于某个分类的图片,我们需要判断分类器在训练阶段有没有见过这个分类。在这个任务中 一个重要的问题是如何减少对于spurious-discriminative特征的依赖。

那么什么是spurious-discriminative特征呢?spurious-discriminative特征指的是在训练集中具有区分度,但是实际并不是独属于某一类的特征。比如说在下面这张图里大角羊的有角就是这样一个特征,我们发现在训练集中,大角羊是唯一具有这个特征的分类,可是在训练集之外,有很多其他分类也都有角。

由此来说,如果模型应该只关注训练集而产生了 有角是独属于大角羊的特征的错觉的话,这就可能会误导模型对于开放集的判定。

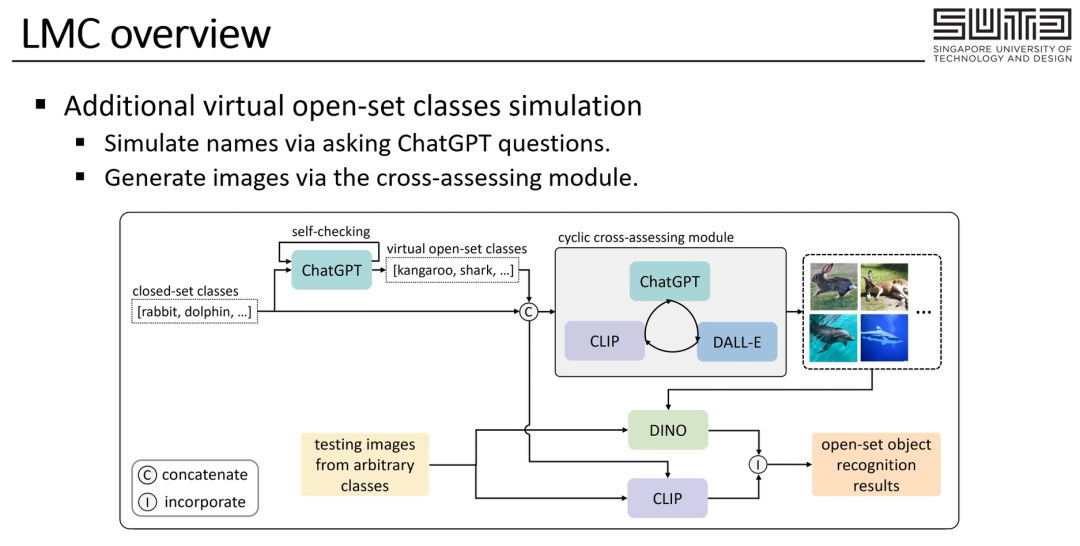

为了解决这个问题,我们利用了不同的大模型的合作与相互的评估。具体来说,给定在训练集中存在的类别。

我们首先借助ChatGPT丰富的知识来生成一些其他类别,从而使得这些类别也具有这种spurious-discriminative特征,由此我们就可以刻意显性地强调,这种spurious-discriminative特征 并不是某一类所独有的。

除此之外,考虑到类别的图像往往比名字具有更多的细节,我们进一步通过大模型间的cross-assessing,也就是相互评估来为每类生成各种各样的图像来使得每一类可以被更好地理解。

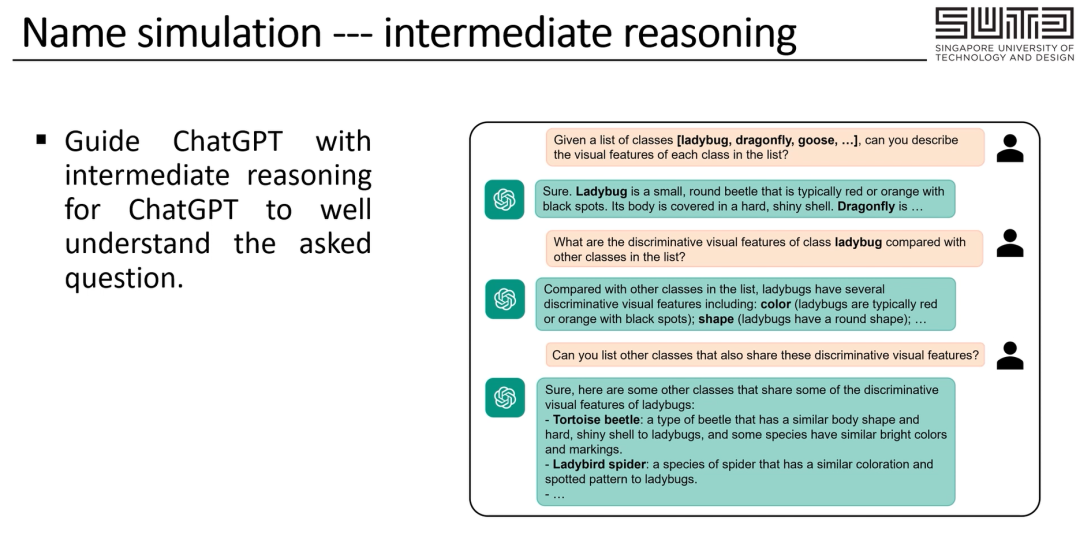

具体来说,为了让ChatGPT可以更好地生成上一页中所说的,具有spurious-discriminative特征的虚拟开放集,我们在与ChatGPT的交互中给出了两个设计。

首先如右图所示,我们使用中间逻辑来一步步地引导ChatGPT来更好地理解我们的目的与需求。

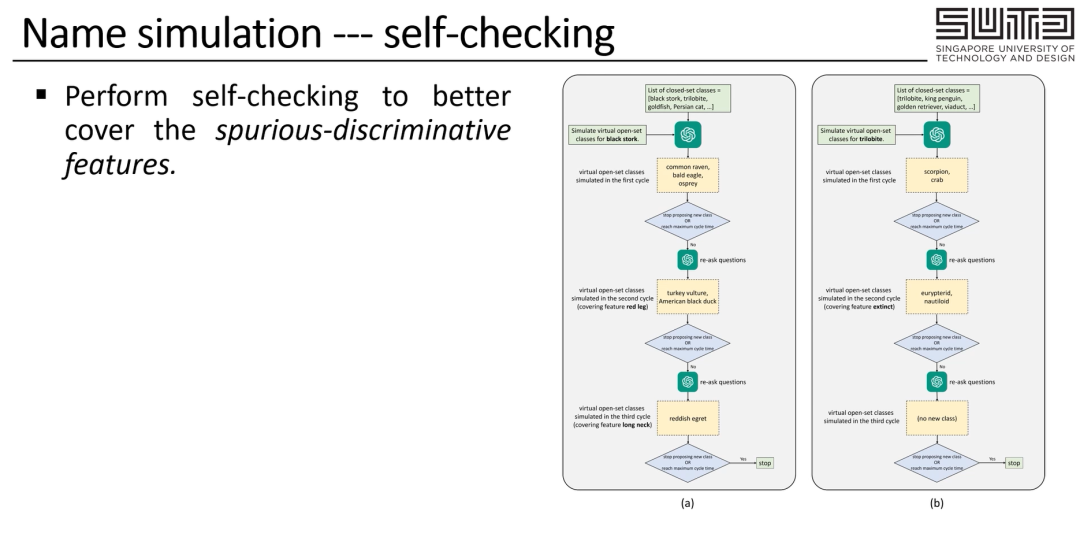

同时为了让ChatGPT更全面地考虑到更多的spurious-discriminative特征,我们也进一步地引导ChatGPT 在每一轮结束之后进行自检,关于以上两个设计的细节,我们也推荐感兴趣的读者阅读我的论文原文来更进一步的理解。

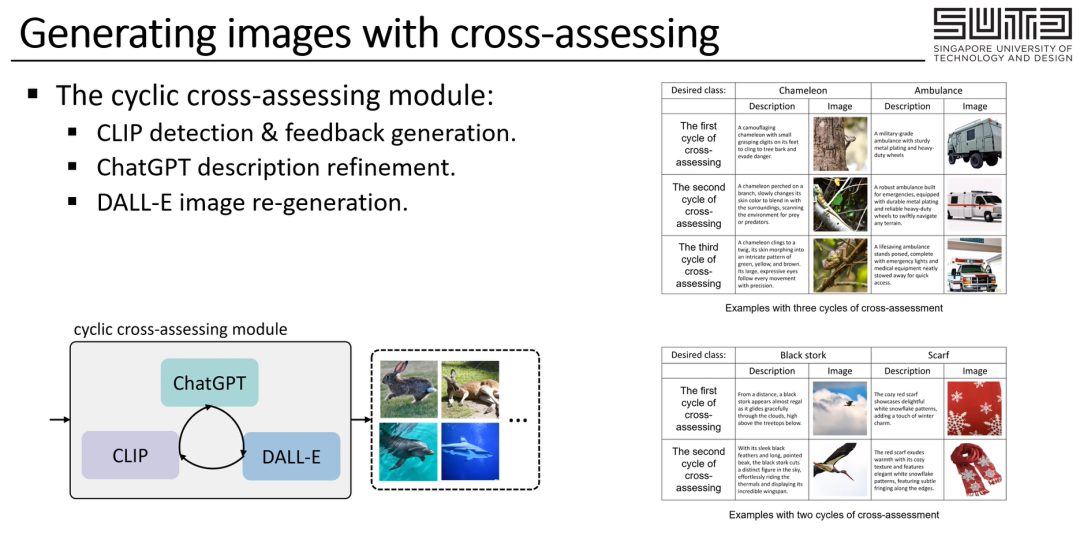

在通过ChatGPT得到虚拟开放集中类别的名字之后,我们想要进一步通过为每一类生成多样图片的方式来捕捉到每一类的更多细节。在这里为了达成这个目的 一种简单的方式,就是直接使用ChatGPT为每一类生成多样的描述,再使用这些描述来引导DALL-E做图片生成。

然而就如下图所示,这种方式往往并不能生成很精确的图片:

比如第一行中,基于描述生成的圣诞树这张图片就与我们常规意义上理解的圣诞树有所差距。

由此我们提出了一个cross-assessing模块,在这个模块中 我们通过引导具有不同知识与能力的大模型互相评估的方式来生成具有更高质量的图片。我们也在右图中展示了我们的模块是如何循环迭代的,一步一步地从上到下来提升图像质量的。

我们的模块通过循环进行这三步来运转:

第一步用模型来提供反馈;第二步,引导ChatGPT模型基于反馈来改善生成的描述;第三步,让DALL-E模型使用改善后的描述来生成图像。

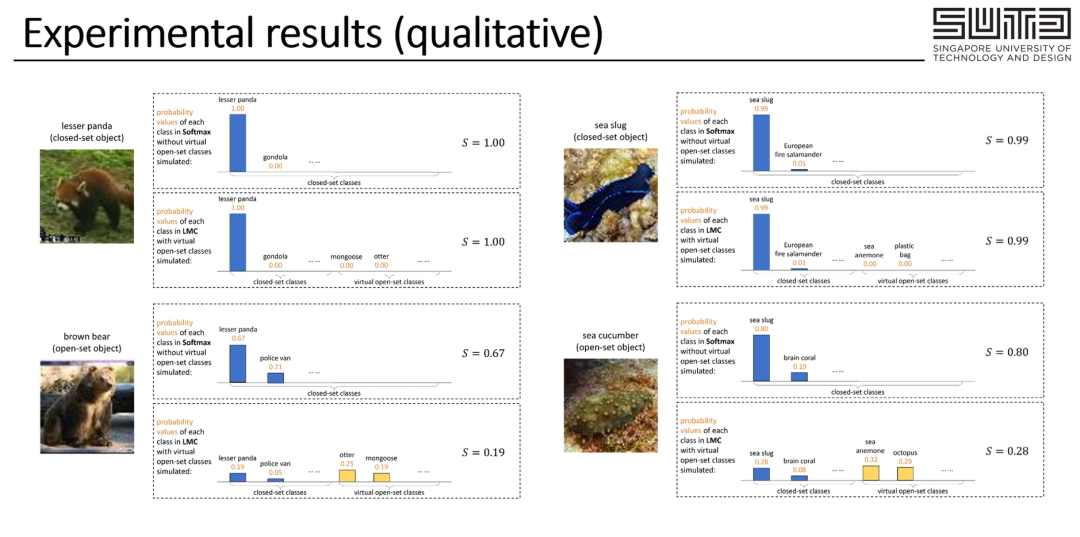

关于这一部分的更多细节基于时间的考量,我们同样建议感兴趣的读者阅读的原文。在这一页与下一页中,我们则展示了一些实验结果,如本篇的图中所展示的一样:

我们提出的LMC框架可以有效地避免开放集图片被误认为属于训练集,同时,我们也在现有常用的数据集与评估指标上,以无需训练的方式达到了比之前需要训练的方式更好的结果。

READ PAPER

Q1 论文试图解决什么问题?

本文试图降低开放集识别任务对于spurious-discriminative特征的依赖。

Q2 这是否是一个新的问题?

这不是一个由本文新提出的问题。

Q3 这篇文章要验证一个什么科学假设?

本文旨在探索,具有丰富且各异知识的不同的现有大模型,能否互相合作与相互评估,来使得问题得以被更好的解决。

Q4 有哪些相关研究?如何归类?谁是这一课题在领域内值得关注的研究员?

与本文相关的研究主要可以被归为以下两类,即开放集识别任务上相关的现有研究,以及与大模型相关的现有研究。

Q5 论文中提到的解决方案之关键是什么?

本文解决方案的关键在于,通过大模型间合作的方式,生成也具有spurious-discriminative特征的虚拟开放集类别。

Q6 论文中的实验是如何设计的?

本文中的实验在设定上,主要沿用了之前开放集识别这一任务上的实验设定,主要采用AUROC与OSCR两种指标进行实验评估。

Q7 用于定量评估的数据集是什么?代码有没有开源?

沿用前文,本文使用CIFAR10,CIFAR+10,CIFAR+50,TinyImageNet四个数据集进行定量评估。代码已开源。

Q8 论文中的实验及结果有没有很好地支持需要验证的科学假设?

本文实验发现,由多个大模型合作与互相评估得到的LMC框架,在各项指标上都取得了最优的结果。这彰显了这一我们提出的框架的有效性。

Q9 这篇论文到底有什么贡献?

我们工作的贡献概述如下。

1)我们提出的 LMC 是一个新颖的框架,它可以通过协作不同的现成预训练大模型的方式,以互补的方式利用它们的知识,以免训练的方式处理开放集物体识别任务。

2)我们在 LMC 中引入了几种设计,以有效地从大型模型中提取文本和图像信息。

3)在评估基准上,LMC 实现了最先进的性能。

Q10 下一步呢?有什么工作可以继续深入?

下面,我们列出了后续研究工作可以进一步探究的几种可能的新方法:(1)如何将大型模型与传统的开放集物体识别方法相结合,以进一步提高性能;(2)如何通过黑盒优化算法(如 CMA 进化策略)促进黑盒大型模型在我们框架中的使用。