文章目录

🔊博主介绍

文章目录

🥤本文内容

起因

我在一台阿里云服务器部署了一主二从的MySQL集群,然后通过程序,控制每秒写入一万条数据入库,想看看消耗的资源情况

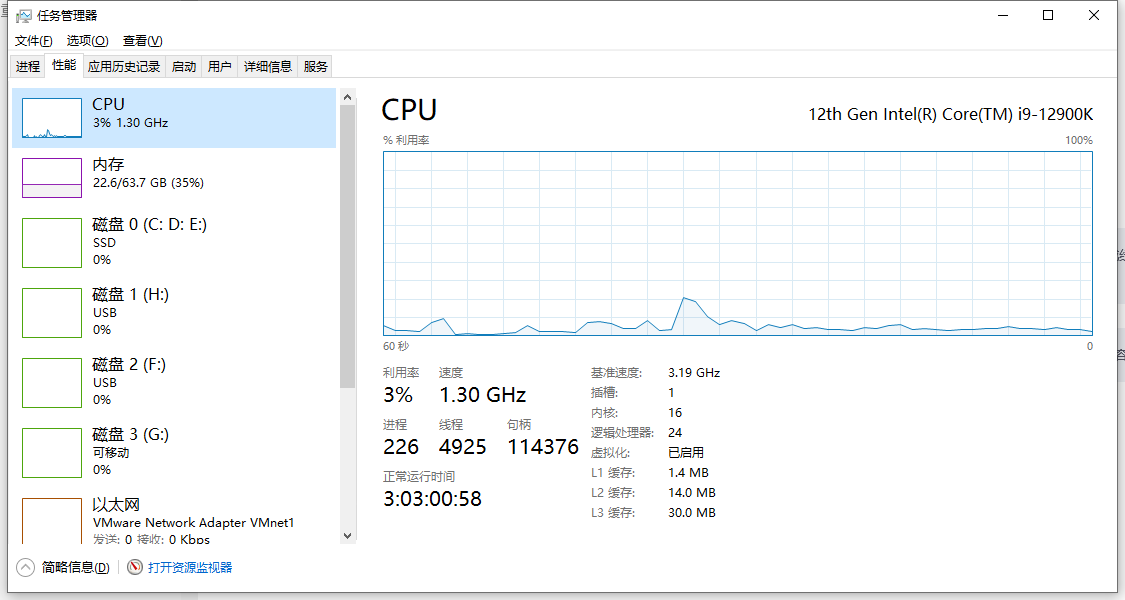

我本地跑的机器如下:

网络用的是手机开的热点,使用的是5G网络

网络用的是手机开的热点,使用的是5G网络

代码

private ScheduledExecutorService poolExecutor;

private ScheduledFuture<?> scheduledFuture;

public void startCreateUserTask() {

// 初始化线程池

poolExecutor = new ScheduledThreadPoolExecutor(

Runtime.getRuntime().availableProcessors() * 2);

// 提交定时任务,并保存返回的ScheduledFuture对象

scheduledFuture = poolExecutor.scheduleAtFixedRate(() -> {

List<TbUser> userList = new ArrayList<>(10000);

for (int i = 0; i < 10000; i++) {

TbUser tbUser = new TbUser();

tbUser.setIsDelete(0);

tbUser.setUserStatus(1);

String uid = UUID.randomUUID().toString();

tbUser.setNickename("liaozhiwei" + uid);

tbUser.setUsername("liaozhiwei" + uid);

tbUser.setPassword("liao" + uid);

userList.add(tbUser);

}

Integer usersave = tbUserMapper.batchInsert(userList);

log.info("批量保存用户数量:" + usersave);

},

0, //这是首次执行任务前的延迟时间。它表示从当前时间开始到首次执行任务所需的等待时间。配置为0,表示无需等待

1, TimeUnit.SECONDS);//这是任务执行的周期时间。每次任务执行完毕后,都会等待这个时间段后再次执行任务。

}

public void stopCreateUserTask() {

// 如果scheduledFuture不为null,则取消定时任务

if (scheduledFuture != null && !scheduledFuture.isCancelled()) {

scheduledFuture.cancel(true); // 传入true表示如果任务正在执行,则中断它

}

// 关闭线程池

if (poolExecutor != null && !poolExecutor.isShutdown()) {

poolExecutor.shutdown(); // 这不会立即停止所有任务,而是启动关闭过程

}

}

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd" >

<mapper namespace="com.yunxi.user.mapper.TbUserMapper" >

<resultMap id="BaseResultMap" type="com.yunxi.user.model.po.TbUser" >

<id column="id" property="id" jdbcType="INTEGER" />

<result column="username" property="username" jdbcType="VARCHAR" />

<result column="password" property="password" jdbcType="VARCHAR" />

<result column="Is_Delete" property="isDelete" jdbcType="INTEGER" />

<result column="user_status" property="userStatus" jdbcType="INTEGER" />

<result column="nickename" property="nickename" jdbcType="VARCHAR" />

</resultMap>

<!-- 用于select查询公用抽取的列 -->

<sql id="Base_Column_List">

t.id,t.username,t.password,t.Is_Delete,t.user_status,t.nickename

</sql>

<!-- batch insert -->

<insert id="batchInsert" parameterType="java.util.List">

INSERT INTO tb_user (username,password,Is_Delete,user_status,nickename)

VALUES

<foreach collection="userList" item="item" index="index" separator="," >

(

#{item.username},

#{item.password},

#{item.isDelete},

#{item.userStatus},

#{item.nickename}

)

</foreach>

</insert>

spring:

datasource:

type: com.alibaba.druid.pool.DruidDataSource

driver-class-name: com.mysql.cj.jdbc.Driver

url: jdbc:mysql://8.138.100.27:33061/user?characterEncoding=UTF-8&allowMultiQueries=true&serverTimezone=GMT%2B8

username: root

password: node1master1root

druid:

filters: stat,wall,slf4j

initial-size: 50

min-idle: 100

max-active: 20000

max-wait: 60000

time-between-eviction-runs-millis: 60000

min-evictable-idle-time-millis: 300000

test-while-idle: true

test-on-borrow: false

test-on-return: false

web-stat-filter:

enabled: true

url-pattern: /*

session-stat-enable: true

session-stat-max-count: 1000

stat-view-servlet:

enabled: true

url-pattern: /druid/*

reset-enable: true

login-username: admin

login-password: admin123

资源情况

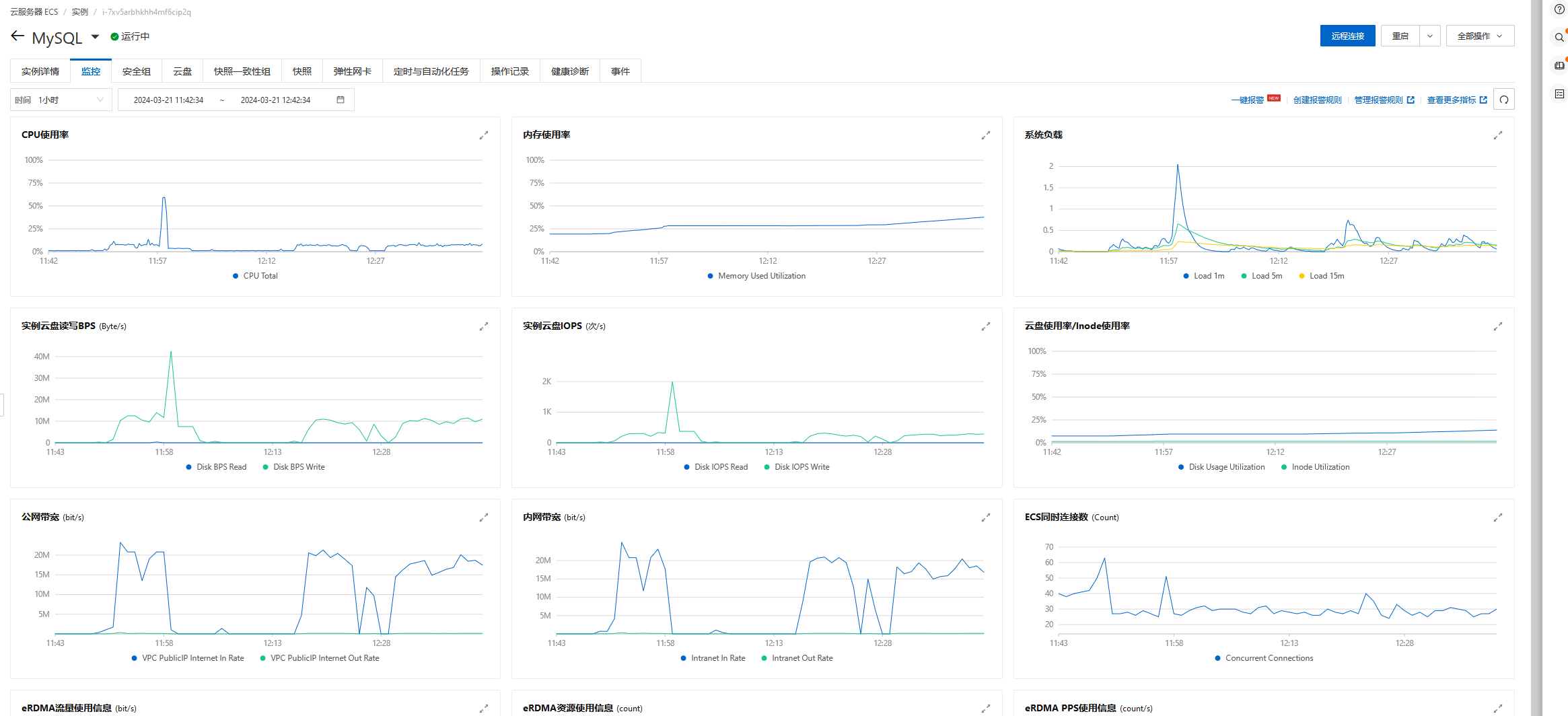

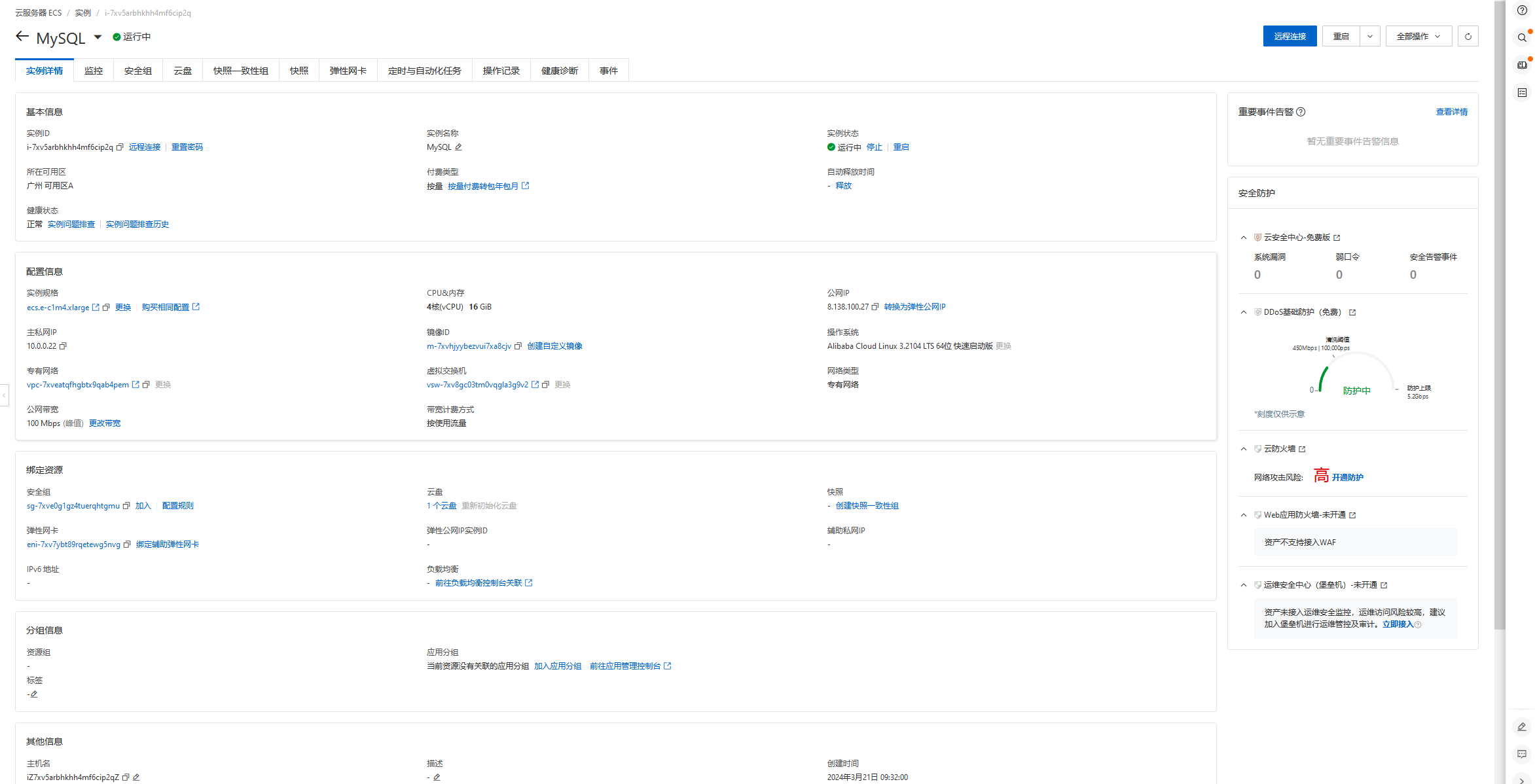

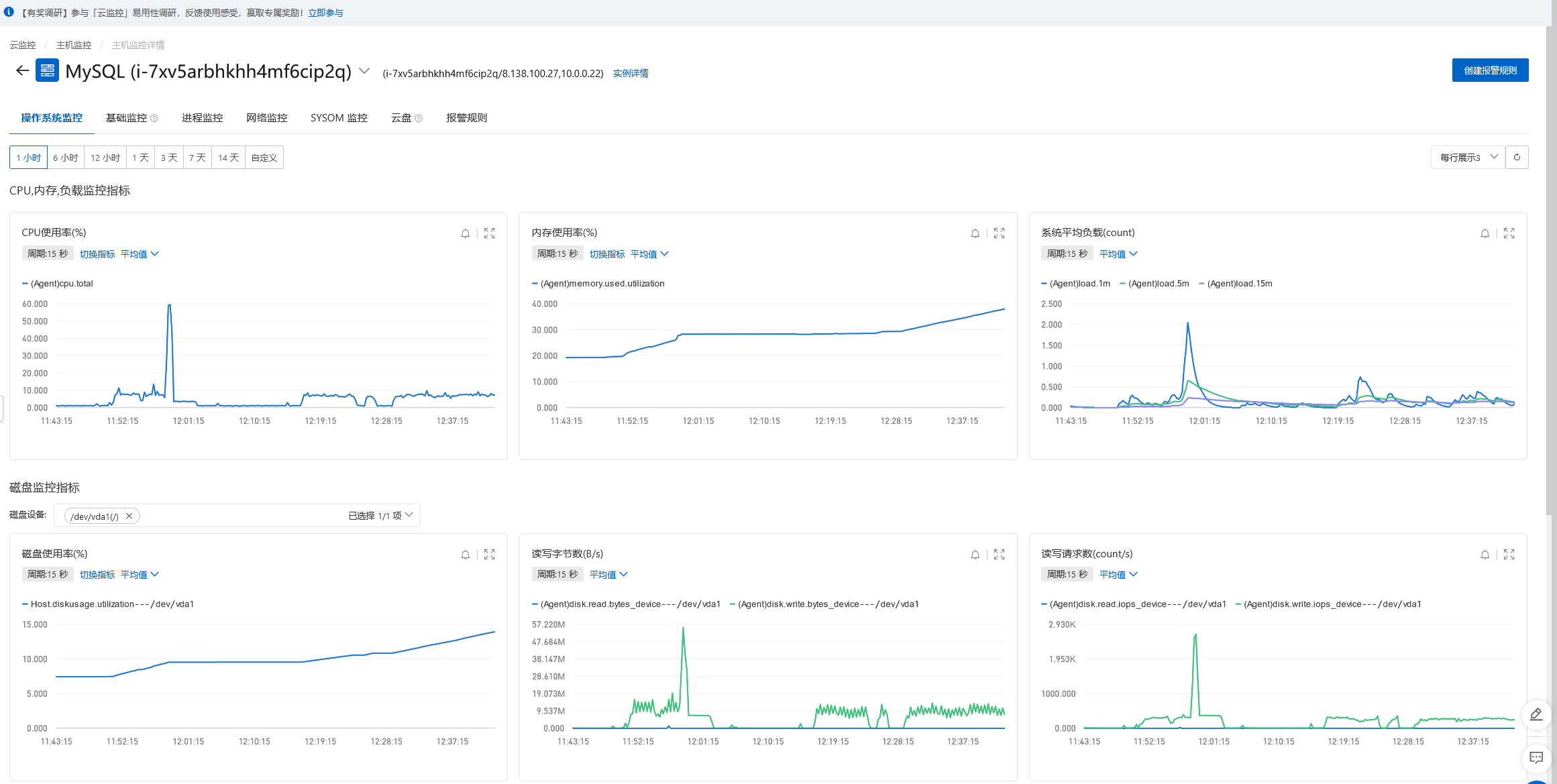

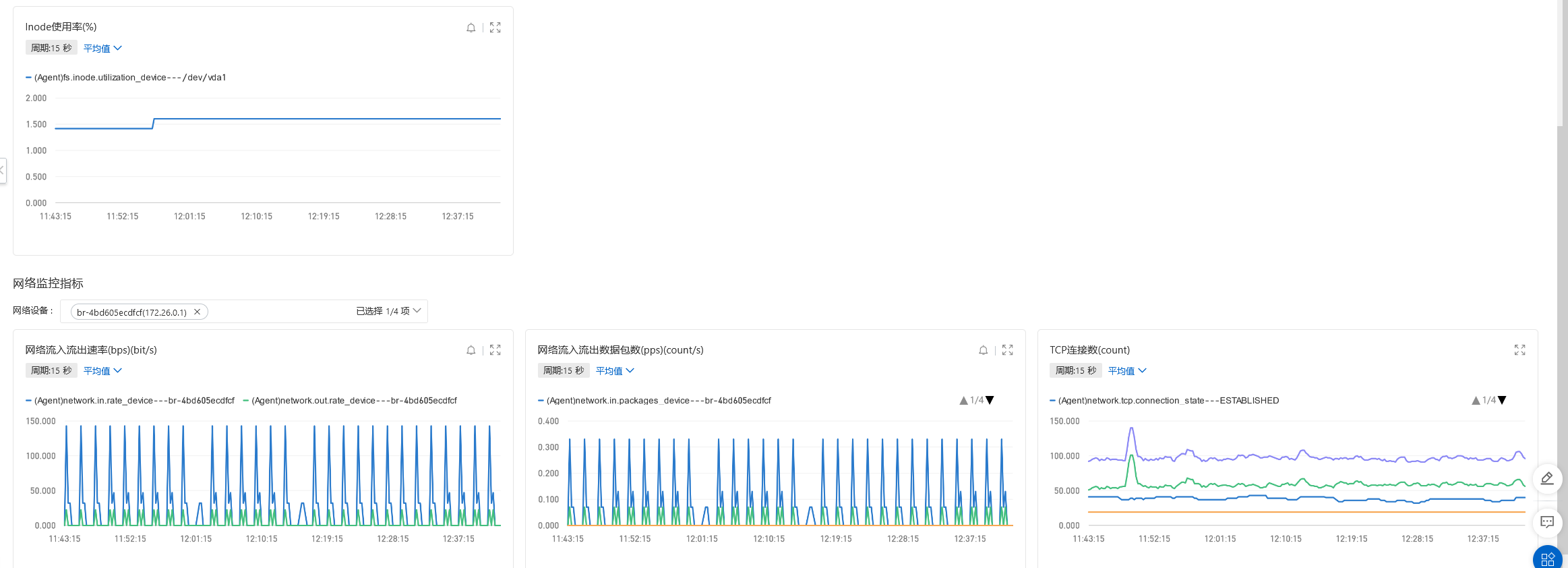

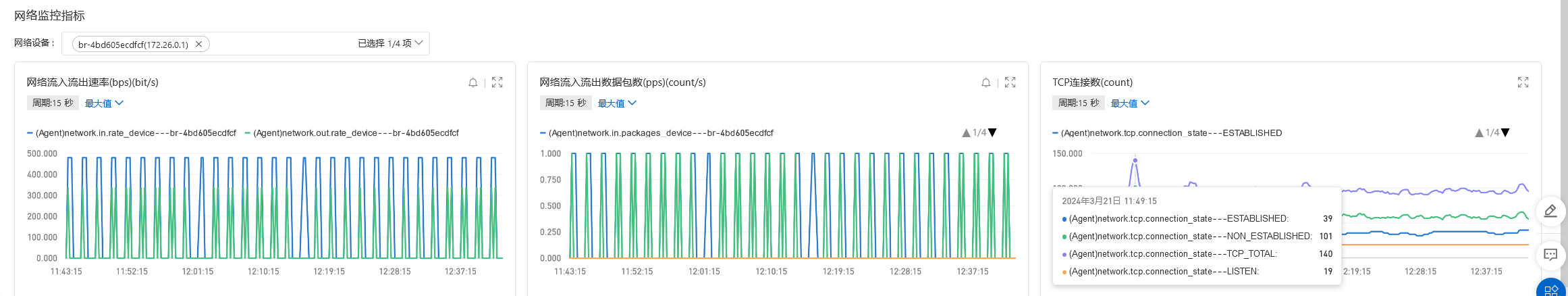

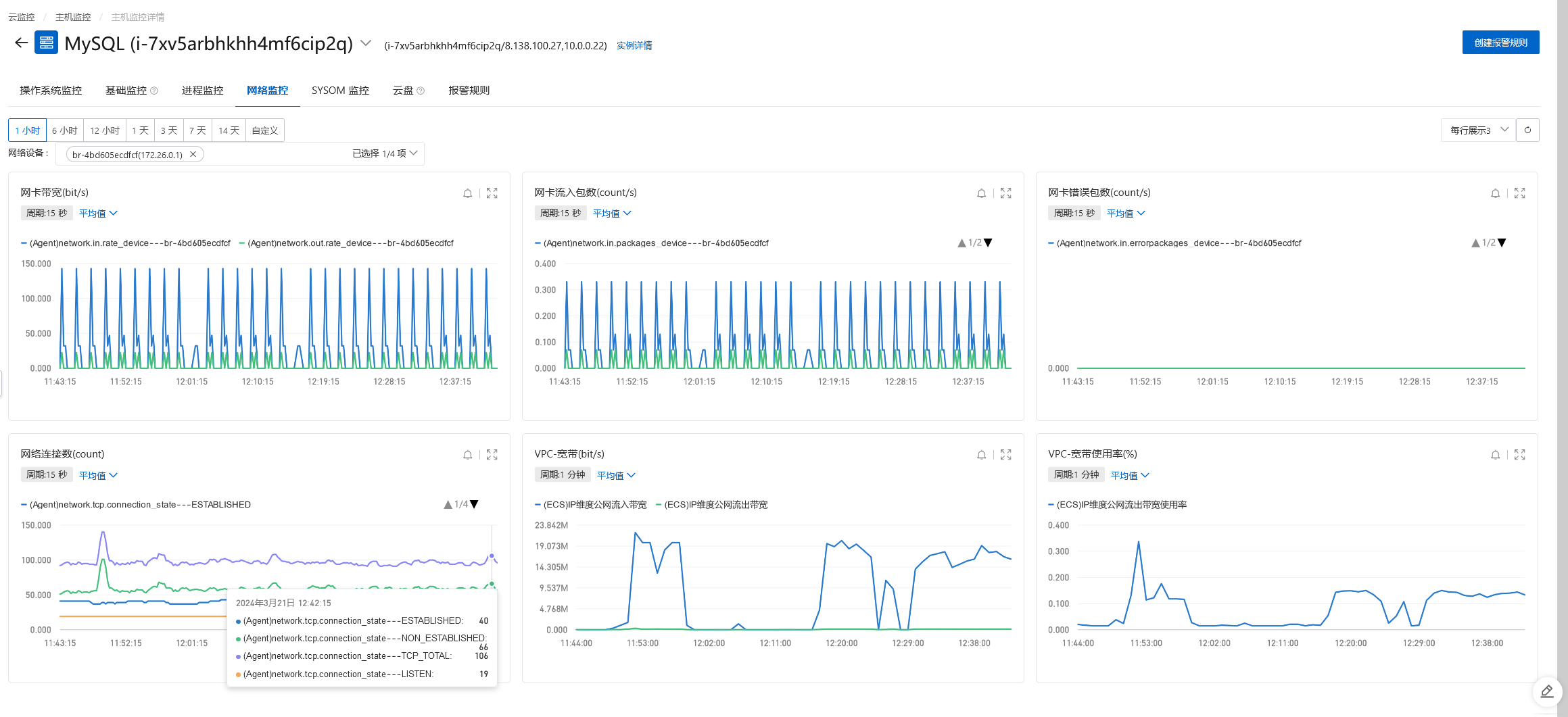

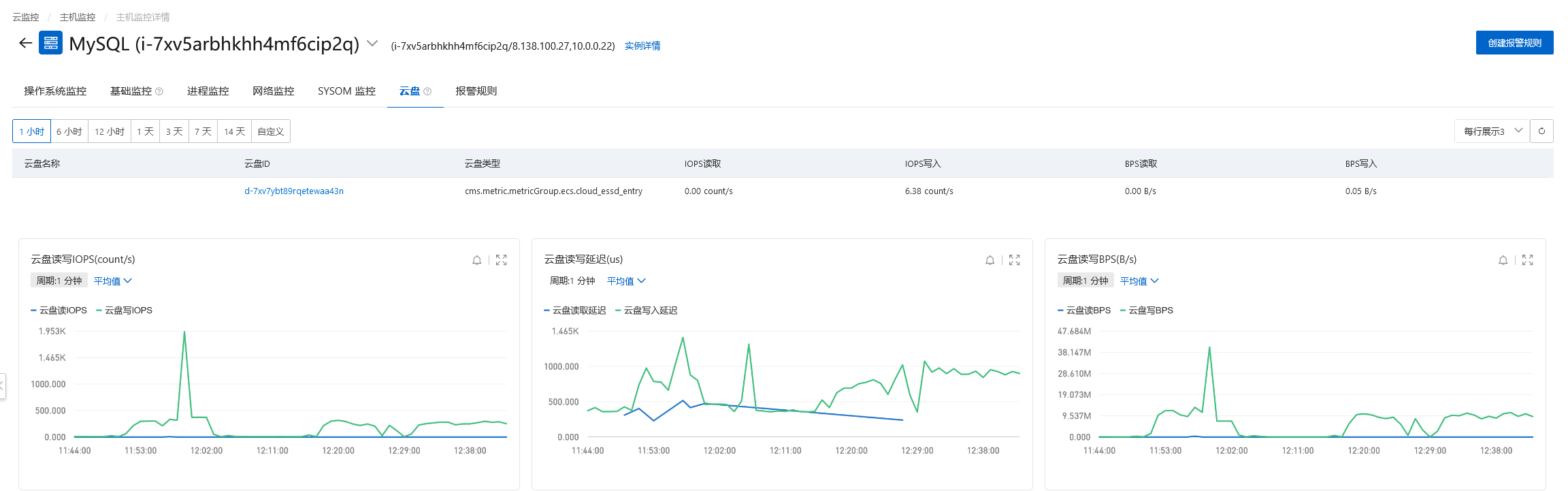

网络带宽低于每秒20M,实例云盘IOPS(次/s)低于400,连接数、CPU使用率、内存使用率、负载情况都比较低,我的服务器配置如下:

4核(vCPU),16 GiB经济型的服务器配置。只对主库进行插入。

在没有什么并发量的场景下,批量插入的数据十几分钟就可以到一千万,虽然不是很快,毕竟控制了插入的量和频率,插入的数据比较稳定,没有数据丢失的情况。

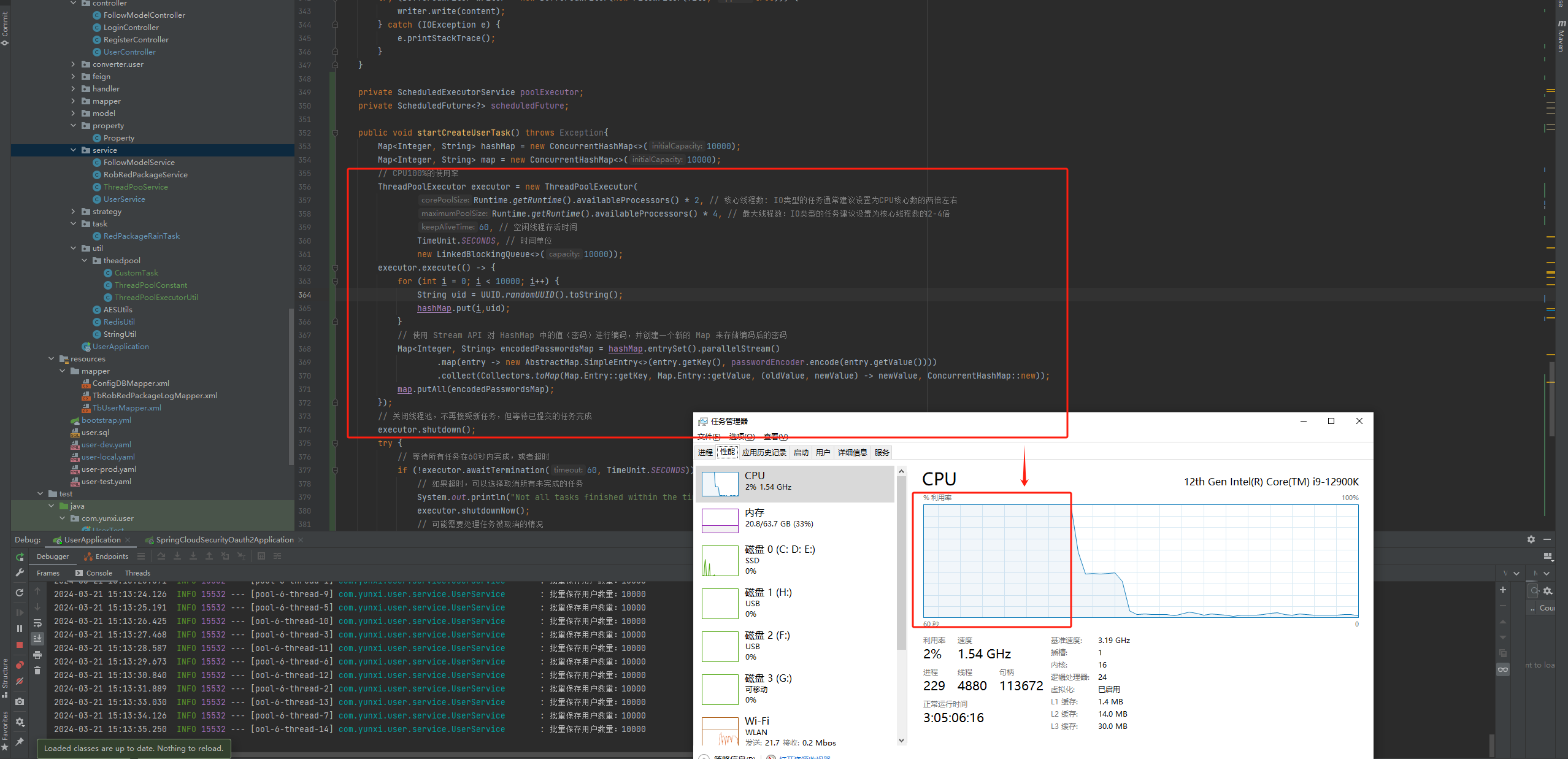

改造

private ScheduledExecutorService poolExecutor;

private ScheduledFuture<?> scheduledFuture;

public void startCreateUserTask(){

Map<Integer, String> hashMap = new ConcurrentHashMap<>(10000);

Map<Integer, String> map = new ConcurrentHashMap<>(1000);

// CPU100%的使用率

ThreadPoolExecutor executor = new ThreadPoolExecutor(

Runtime.getRuntime().availableProcessors() * 2, // 核心线程数: IO类型的任务通常建议设置为CPU核心数的两倍左右

Runtime.getRuntime().availableProcessors() * 4, // 最大线程数:IO类型的任务建议设置为核心线程数的2-4倍

60, // 空闲线程存活时间

TimeUnit.SECONDS, // 时间单位

new LinkedBlockingQueue<>(10000));

executor.execute(() -> {

for (int i = 0; i < 10000; i++) {

String uid = UUID.randomUUID().toString();

hashMap.put(i,uid);

}

// 使用 Stream API 对 HashMap 中的值(密码)进行编码,并创建一个新的 Map 来存储编码后的密码

Map<Integer, String> encodedPasswordsMap = hashMap.entrySet().parallelStream()

.map(entry -> new AbstractMap.SimpleEntry<>(entry.getKey(), passwordEncoder.encode(entry.getValue())))

.collect(Collectors.toMap(Map.Entry::getKey, Map.Entry::getValue, (oldValue, newValue) -> newValue, ConcurrentHashMap::new));

map.putAll(encodedPasswordsMap);

});

// 关闭线程池,不再接受新任务,但等待已提交的任务完成

executor.shutdown();

try {

// 等待所有任务在60秒内完成,或者超时

if (!executor.awaitTermination(60, TimeUnit.SECONDS)) {

// 如果超时,可以选择取消所有未完成的任务

System.out.println("Not all tasks finished within the timeout period. Cancelling remaining tasks.");

executor.shutdownNow();

// 可能需要处理任务被取消的情况

} else {

System.out.println("All tasks have completed.");

}

} catch (InterruptedException ie) {

// 如果等待期间线程被中断,重新中断当前线程

executor.shutdownNow();

Thread.currentThread().interrupt();

}

if (map.size() == 10000) {

// 初始化线程池

poolExecutor = new ScheduledThreadPoolExecutor(

Runtime.getRuntime().availableProcessors() * 2);

// 提交定时任务,并保存返回的ScheduledFuture对象

scheduledFuture = poolExecutor.scheduleAtFixedRate(() -> {

List<TbUser> userList = new ArrayList<>(10000);

for (int i = 0; i < 10000; i++) {

TbUser tbUser = new TbUser();

tbUser.setIsDelete(0);

tbUser.setUserStatus(1);

String uid = UUID.randomUUID().toString();

tbUser.setNickename("liaozhiwei" + uid);

tbUser.setUsername("liaozhiwei" + uid);

tbUser.setPassword(map.get(i));

userList.add(tbUser);

}

Integer usersave = tbUserMapper.batchInsert(userList);

log.info("批量保存用户数量:" + usersave);

},

0, //这是首次执行任务前的延迟时间。它表示从当前时间开始到首次执行任务所需的等待时间。配置为0,表示无需等待

1, TimeUnit.SECONDS);//这是任务执行的周期时间。每次任务执行完毕后,都会等待这个时间段后再次执行任务。

}

}

public void stopCreateUserTask() {

// 如果scheduledFuture不为null,则取消定时任务

if (scheduledFuture != null && !scheduledFuture.isCancelled()) {

scheduledFuture.cancel(true); // 传入true表示如果任务正在执行,则中断它

}

// 关闭线程池

if (poolExecutor != null && !poolExecutor.isShutdown()) {

poolExecutor.shutdown(); // 这不会立即停止所有任务,而是启动关闭过程

}

}

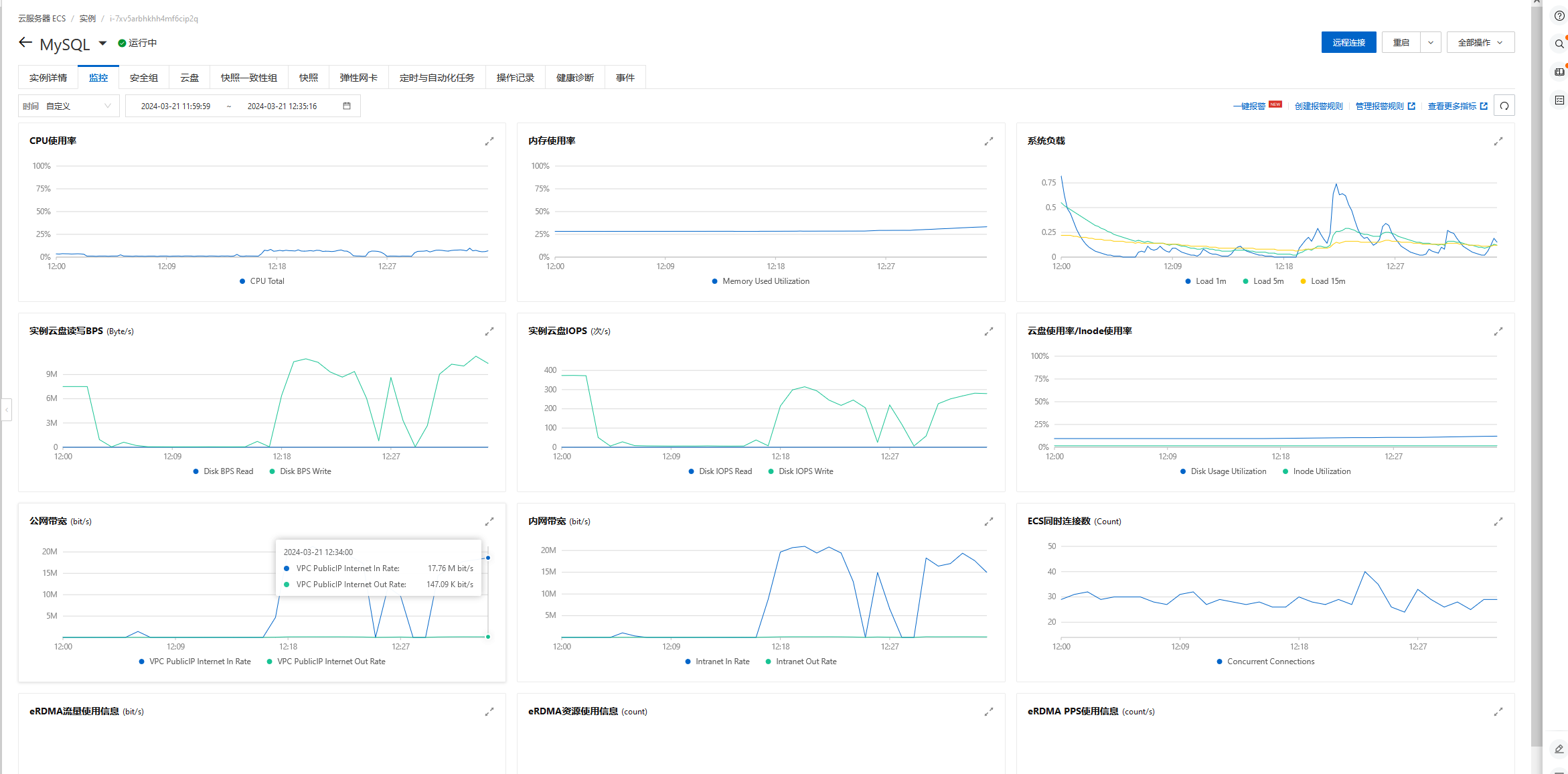

将代码调整后,一次插入100000,多了十倍,但是执行的时间也是多了十倍多,时间会多一丢丢,推断可能和我的网络有关,手机热点传输低于服务器带宽,传输有限,所以本机测试,一秒一万是最合适的。如果上服务器,执行效率应该会更高一点。

线程资源使用率100%,最大程度对密码进行加密计算,缩短计算时长。

线程资源使用率100%,最大程度对密码进行加密计算,缩短计算时长。

📢文章总结

对本篇文章进行总结:

🔔以上就是今天要讲的内容,阅读结束后,反思和总结所学内容,并尝试应用到现实中,有助于深化理解和应用知识。与朋友或同事分享所读内容,讨论细节并获得反馈,也有助于加深对知识的理解和吸收。

🔔如果您需要转载或者搬运这篇文章的话,非常欢迎您私信我哦~

- 💂 博客主页: 我是廖志伟

- 👉开源项目:java_wxid

- 🌥 哔哩哔哩:我是廖志伟

- 🎏个人社区:幕后大佬

- 🔖个人微信号:

SeniorRD - 🎉微信号二维码:

📥博主目标

- 🍋程序开发这条路不能停,停下来容易被淘汰掉,吃不了自律的苦,就要受平庸的罪,持续的能力才能带来持续的自信。我本是一个很普通的程序员,放在人堆里,除了与生俱来的盛世美颜,就剩180的大高个了,就是我这样的一个人,默默写博文也有好多年了。

- 📺有句老话说的好,牛逼之前都是傻逼式的坚持,希望自己可以通过大量的作品、时间的积累、个人魅力、运气、时机,可以打造属于自己的技术影响力。

- 💥内心起伏不定,我时而激动,时而沉思。我希望自己能成为一个综合性人才,具备技术、业务和管理方面的精湛技能。我想成为产品架构路线的总设计师,团队的指挥者,技术团队的中流砥柱,企业战略和资本规划的实战专家。

- 🎉这个目标的实现需要不懈的努力和持续的成长,但我必须努力追求。因为我知道,只有成为这样的人才,我才能在职业生涯中不断前进并为企业的发展带来真正的价值。在这个不断变化的时代,我们必须随时准备好迎接挑战,不断学习和探索新的领域,才能不断地向前推进。我坚信,只要我不断努力,我一定会达到自己的目标。

可访问:https://java_wxid.gitee.io/tojson/