目录

深度学习中的注意力机制(Attention Mechanism)是一种模仿人类视觉和认知系统的方法,它允许神经网络在处理输入数据时集中注意力于相关的部分。通过引入注意力机制,神经网络能够自动地学习并选择性地关注输入中的重要信息,提高模型的性能和泛化能力。

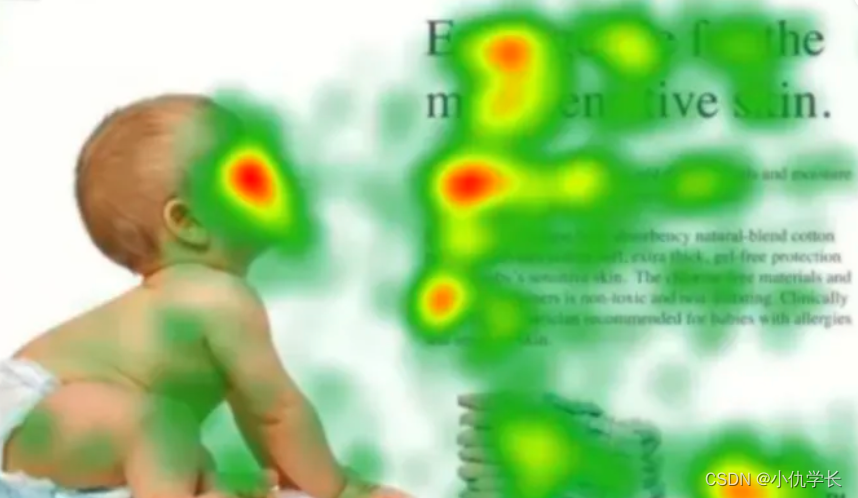

下图 展示了人类在看到一幅图像时如何高效分配有限注意力资源的,其中红色区域表明视觉系统更加关注的目标,从图中可以看出:人们会把注意力更多的投入到人的脸部。文本的标题以及文章的首句等位置。

具体计算过程:

①根据Query和Key计算两者的相似性或相关性。常见方法:求两者的向量点积(内积)、求两者向量Cosine相似性、引入额外的神经网络求值(MLP)。

②对注意力得分进行softmax归一化处理。

③根据权重系数对value进行加权求和。