小林coding网站通道:入口

本篇文章摘抄应付面试的重点内容,详细内容还请移步:小林coding网站通道

文章目录

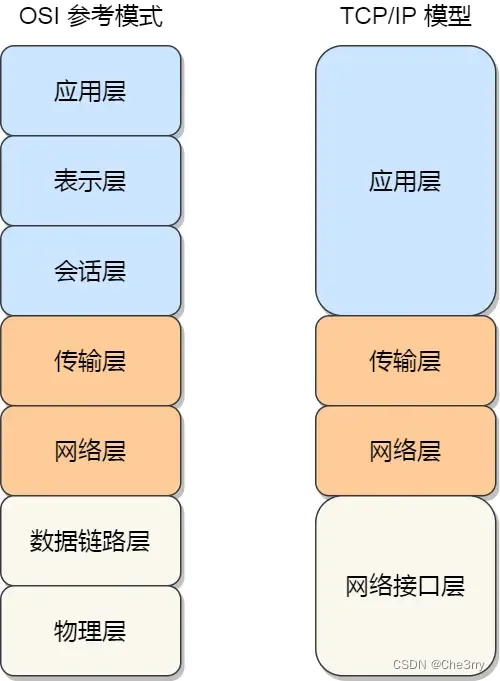

网络模型

事实上,我们比较常见,也比较实用的是四层模型,即 TCP/IP 网络模型,Linux 系统正是按照这套网络模型来实现网络协议栈的。

Linux 网络协议栈

首先我们需要了解TCP/IP网络模型,以及网络包的封装原理。

Linux网络协议栈就类似于TCP/IP的四层结构。

LVS是什么?

LVS(Linux Virtual Server)是Linux系统中用于实现负载均衡的高性能和高可用性服务。它主要用于构建可扩展、高可用的网络服务,如Web、邮件、媒体流等。通过LVS,可以将网络请求分发到由多个服务器组成的服务器集群中,这样不仅可以提高服务的处理能力,还可以提高服务的可用性和可靠性。

LVS工作在网络的传输层,它使用IP层的负载均衡技术,支持多种负载均衡算法,包括轮询(Round Robin)、加权轮询(Weighted Round Robin)、最少连接(Least Connections)、加权最少连接(Weighted Least Connections)等。这些算法可以根据实际需求灵活选择,以达到最优的负载均衡效果。

LVS的负载均衡机制主要有三种模式:

-

NAT(Network Address Translation)模式:在这种模式下,请求会被转发到内部服务器,而内部服务器的响应则被发送回LVS服务器,然后再由LVS服务器发送给客户端。这种方式简单易于部署,但可能会因为所有的响应数据都需要经过LVS服务器而成为瓶颈。

-

直接路由(Direct Routing)模式:客户端的请求直接路由到后端服务器,而响应则直接从后端服务器返回给客户端,绕过了LVS服务器。这种模式能够减少LVS服务器的负载,提高系统的处理能力,但需要在网络配置上做一些额外的工作。

-

隧道模式(TUN/IP Tunneling):在这种模式下,请求被封装在IP隧道中并直接发送到最终的服务器。这种方式适用于跨越不同网络的负载均衡,但可能需要在服务器上进行额外的配置。

Socket是什么?

Socket是一种抽象层,它为在不同主机间进行数据交换提供了一组编程接口(API)。它是网络通信的基石,提供了构建多种网络应用的基础,包括Web服务器、电子邮件客户端、聊天程序等。Socket使得程序可以读写数据,就像对本地文件进行操作一样简单。

Socket为网络通信提供了一个统一的编程接口,简化了网络程序的开发。通过使用Socket,开发者可以不必深入了解底层网络协议的细节,就能构建复杂的网络应用。此外,Socket编程接口在不同的操作系统中都有实现,使得基于Socket的应用可以跨平台运行,进一步提高了网络程序的可移植性和灵活性。

Linux 接收网络包的流程

网卡是计算机里的一个硬件,专门负责接收和发送网络包,当网卡接收到一个网络包后,会通过 DMA 技术,将网络包写入到指定的内存地址,也就是写入到 Ring Buffer ,这个是一个环形缓冲区,接着就会告诉操作系统这个网络包已经到达。

DMA技术

DMA(Direct Memory Access)技术是一种允许某些硬件子系统直接读写主内存(RAM),而无需中央处理单元(CPU)介入的计算机系统特性。这种方式可以大大减少CPU的负担和提高整个系统的数据处理效率。

那应该怎么告诉操作系统这个网络包已经到达了呢?

最简单的一种方式就是触发中断,也就是每当网卡收到一个网络包,就触发一个中断告诉操作系统。

但是,在高性能网络场景下,网络包的数量会非常多,那么就会触发非常多的中断那么频繁地触发中断,则会导致 CPU 一直没完没了的处理中断,而导致其他任务可能无法继续前进,从而影响系统的整体效率。

所以为了解决频繁中断带来的性能开销,Linux 内核在 2.6 版本中引入了 NAPI 机制,它是混合「中断和轮询」的方式来接收网络包,它的核心概念就是不采用中断的方式读取数据,而是首先采用中断唤醒数据接收的服务程序,然后 poll 的方法来轮询数据。

因此,当有网络包到达时,会通过 DMA 技术,将网络包写入到指定的内存地址,接着网卡向 CPU 发起硬件中断,当 CPU 收到硬件中断请求后,根据中断表,调用已经注册的中断处理函数。

硬件中断处理函数会做如下的事情:

- 需要先「暂时屏蔽中断」,表示已经知道内存中有数据了,告诉网卡下次再收到数据包直接写内存就可以了,不要再通知 CPU 了,这样可以提高效率,避免 CPU 不停的被中断。

- 接着,发起「软中断」,然后恢复刚才屏蔽的中断。

至此,硬件中断处理函数的工作就已经完成。

软中断的处理

内核中的 ksoftirqd 线程专门负责软中断的处理,当 ksoftirqd 内核线程收到软中断后,就会来轮询处理数据。

ksoftirqd 线程会从 Ring Buffer 中获取一个数据帧,用 sk_buff 表示,从而可以作为一个网络包交给网络协议栈进行逐层处理。

网络协议栈作用

-

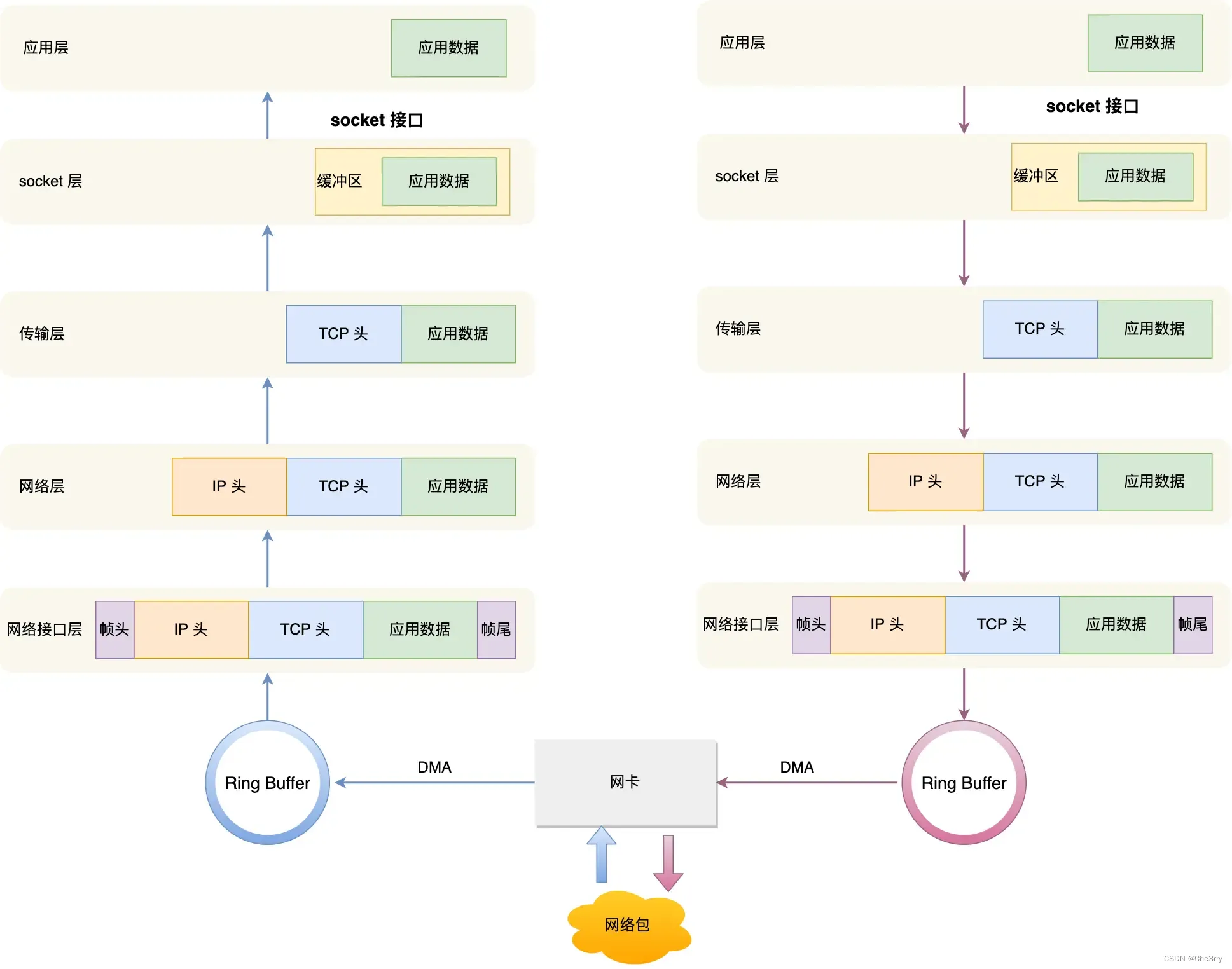

先进入到网络接口层,在这一层会检查报文的合法性,如果不合法则丢弃,合法则会找出该网络包的上层协议的类型,比如是 IPv4,还是 IPv6,接着再去掉帧头和帧尾,然后交给网络层。

-

到了网络层,则取出 IP 包,判断网络包下一步的走向,比如是交给上层处理还是转发出去。当确认这个网络包要发送给本机后,就会从 IP 头里看看上一层协议的类型是 TCP 还是 UDP,接着去掉 IP 头,然后交给传输层。

-

传输层取出 TCP 头或 UDP 头,根据四元组「源 IP、源端口、目的 IP、目的端口」 作为标识,找出对应的 Socket,并把数据放到 Socket 的接收缓冲区。

-

最后,应用层程序调用 Socket 接口,将内核的 Socket 接收缓冲区的数据「拷贝」到应用层的缓冲区,然后唤醒用户进程。

至此,一个网络包的接收过程就已经结束了,你也可以从下图左边部分看到网络包接收的流程,右边部分刚好反过来,它是网络包发送的流程。

Linux发送网络包的流程

发送网络包的流程正好和接收流程相反。如上图中的右半部分。

-

首先,应用程序会调用 Socket 发送数据包的接口,由于这个是系统调用,所以会从用户态陷入到内核态中的 Socket 层,内核会申请一个内核态的 sk_buff 内存,将用户待发送的数据拷贝到 sk_buff 内存,并将其加入到发送缓冲区。

-

接下来,网络协议栈从 Socket 发送缓冲区中取出 sk_buff,并按照 TCP/IP 协议栈从上到下逐层处理。

-

如果使用的是 TCP 传输协议发送数据,那么先拷贝一个新的 sk_buff 副本 (这是因为 sk_buff 后续在调用网络层,最后到达网卡发送完成的时候,这个 sk_buff 会被释放掉)。而 TCP 协议是支持丢失重传的,在收到对方的 ACK 之前,这个 sk_buff 不能被删除。所以内核的做法就是每次调用网卡发送的时候,实际上传递出去的是 sk_buff 的一个拷贝,等收到 ACK 再真正删除。

-

接着,对 sk_buff 填充 TCP 头。这里提一下,sk_buff 可以表示各个层的数据包,在应用层数据包叫 data,在 TCP 层我们称为 segment,在 IP 层我们叫 packet,在数据链路层称为 frame。

至此,传输层的工作也就都完成了。 -

交给网络层,在网络层里会做这些工作:选取路由(确认下一跳的 IP)、填充 IP 头、netfilter 过滤、对超过 MTU 大小的数据包进行分片。处理完这些工作后会交给网络接口层处理。

-

网络接口层会通过 ARP 协议获得下一跳的 MAC 地址,然后对 sk_buff 填充帧头和帧尾,接着将 sk_buff 放到网卡的发送队列中。

-

这一些工作准备好后,会触发**「软中断」告诉网卡驱动程序,这里有新的网络包需要发送,驱动程序会从发送队列中读取 sk_buff**,将这个 sk_buff 挂到 RingBuffer 中,接着将 sk_buff 数据映射到网卡可访问的内存 DMA 区域,最后触发真实的发送。

-

当数据发送完成以后,其实工作并没有结束,因为内存还没有清理。当发送完成的时候,网卡设备会触发一个硬中断来释放内存,主要是释放 sk_buff 内存和清理 RingBuffer 内存。

-

最后,当收到这个 TCP 报文的 ACK 应答时,传输层就会释放原始的 sk_buff 。

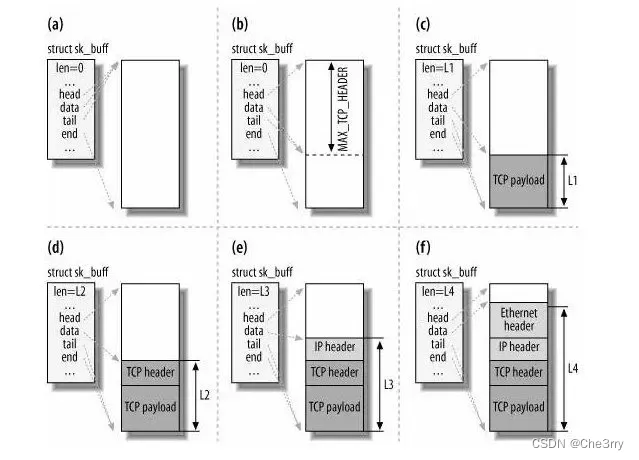

为什么全部数据包只用一个结构体来描述呢

协议栈采用的是分层结构,上层向下层传递数据时需要增加包头,下层向上层数据时又需要去掉包头,如果每一层都用一个结构体,那在层之间传递数据的时候,就要发生多次拷贝,这将大大降低 CPU 效率。

于是,为了在层级之间传递数据时,不发生拷贝,只用 sk_buff 一个结构体来描述所有的网络包,那它是如何做到的呢?是通过调整 sk_buff 中 data 的指针,比如:

- 当接收报文时,从网卡驱动开始,通过协议栈层层往上传送数据报,通过增加 skb->data 的值,来逐步剥离协议首部。

- 当要发送报文时,创建 sk_buff 结构体,数据缓存区的头部预留足够的空间,用来填充各层首部,在经过各下层协议时,通过减少 skb->data 的值来增加协议首部。

你可以从下面这张图看到,当发送报文时,data 指针的移动过程。

发送网络数据的时候,涉及几次内存拷贝操作?

-

第一次,调用发送数据的系统调用的时候,内核会申请一个内核态的 sk_buff 内存,将用户待发送的数据拷贝到 sk_buff 内存,并将其加入到发送缓冲区。

-

第二次,在使用 TCP 传输协议的情况下,从传输层进入网络层的时候,每一个 sk_buff 都会被克隆一个新的副本出来。副本 sk_buff 会被送往网络层,等它发送完的时候就会释放掉,然后原始的 sk_buff 还保留在传输层,目的是为了实现 TCP 的可靠传输,等收到这个数据包的 ACK 时,才会释放原始的 sk_buff 。

-

第三次,当 IP 层发现 sk_buff 大于 MTU 时才需要进行。会再申请额外的 sk_buff,并将原来的 sk_buff 拷贝为多个小的 sk_buff。