Chinese Tiny LLM: Pretraining a Chinese-Centric Large Language Model

相关链接:arXiv 关键字:Chinese LLM、Pretraining、Large Language Model、Chinese Corpora、Multilingual

摘要

本研究介绍了CT-LLM(Chinese Tiny Large Language Model),这是一个2B参数的大型语言模型(LLM),它标志着在开发LLMs时优先考虑中文的重大转变。CT-LLM的独特之处在于,它从头开始,主要通过包含1200亿个token的广泛语料库进行预训练,其中包括800亿个中文token、300亿个英文token和100亿个代码token。这种战略性组成通过比对技术增强了模型在理解和处理中文方面的卓越能力。CT-LLM在CHC-Bench上的出色表现,展示了其在中文语言任务上的熟练程度,并通过SFT(Supervised Fine-Tuning)展示了其在英文方面的多语言能力。本研究挑战了以英文语料库为主训练LLMs然后适应其他语言的现有范式,为LLM训练方法论拓宽了视野。通过开源训练中文LLM的整个过程,包括详细的数据处理程序、获得的大量适当预训练中文语料库(MAP-CC)和精心挑选的多学科中文难题基准(CHC-Bench),我们旨在促进学术界和工业界的进一步探索和创新,为更具包容性和多功能性的语言模型铺平道路。

核心方法

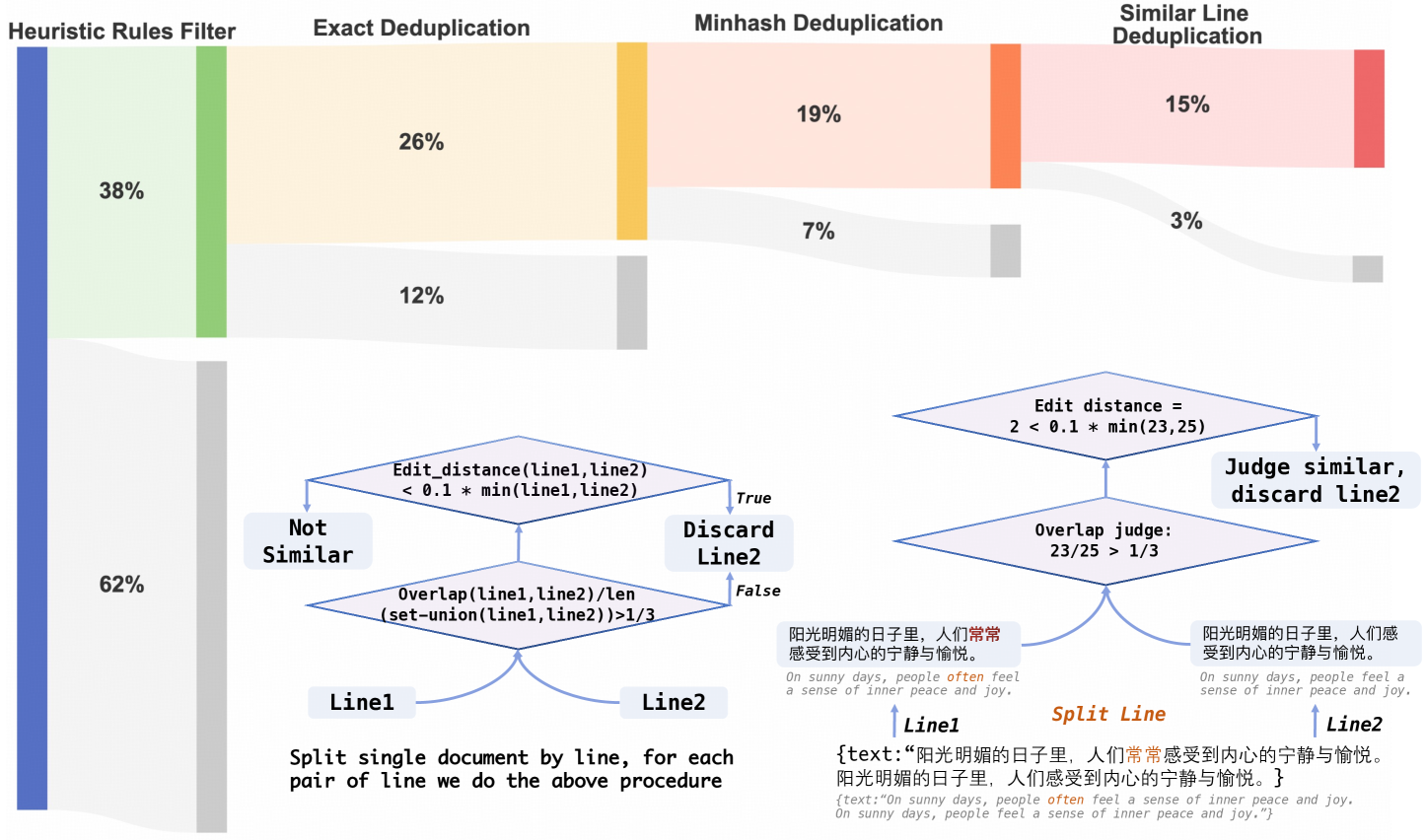

- 数据集构建:开发了一个包含1200亿token的数据集,其中包括800亿中文token、300亿英文token和100亿代码token。通过精心设计的数据过滤规则,提高了中文网络语料库的质量,为数据集准备设定了新的标准。

- 模型架构:基于Transformer解码器,采用了多头注意力机制、RoPE(Rotary Positional Embeddings)嵌入和SwiGLU激活函数等改进,以增强模型性能。

- 预训练:使用上述数据集对模型进行预训练,通过大量的中文数据提高对中文的处理能力。

- 监督微调(SFT):通过在中文和英文数据上进行微调,进一步提升模型在中英文任务上的表现。

- 偏好优化技术:使用DPO(Direct Preference Optimization)技术,根据人类偏好对模型进行优化,以增强其无害性和有用性。

实验说明

实验结果数据展示了CT-LLM在多个公共基准测试中的表现,包括MMLU、C-Eval和CMMLU等。通过与同类规模的其他基础模型进行比较,CT-LLM在多学科数据集上的表现尤为突出,尤其是在理解中文方面。实验数据来源于公开的基准测试集,包括语言建模、问答、逻辑推理等多个方面。

| 模型 | COPA | Hellaswag | MMLU | Humaneval | Triviaqa | Lambada | Squad2.0 | GSM8k | C-Eval | CMMLU |

|---|---|---|---|---|---|---|---|---|---|---|

| CT-LLM(Ours) | 59.0 | 50.37 | 37.11 | 9.15 | 21.03 | 56.24 | 18.87 | 8.87 | 36.78 | 36.4 |

结论

我们开发了CT-LLM,这是一个为中文量身打造的大型语言模型,通过在800亿个token上进行预训练,增强了中文处理能力,并具备多语言适应性。与之前主要依赖英文数据集的模型不同,CT-LLM代表了LLM研究的新方向,它关注中文,并包括英文和代码token。我们使用SFT技术来提高中英文的表现,并引入CHC-Bench来评估模型在复杂任务上的能力。CT-LLM的主要贡献包括提供一个高质量的中文语料库和CHCBench,解决偏见问题,并推进以中文为中心的LLMs。这促进了更广泛的NLP研究、创新和对开源社区的贡献。