Chatbot Arena: An Open Platform for Evaluating LLMs by Human Preference

相关链接:arxiv 关键字:Large Language Models、LLMs、Human Preference、Chatbot Arena、Benchmark Platform

摘要

随着大型语言模型(LLMs)解锁新功能和应用,评估它们与人类偏好的一致性仍然是一个重大挑战。为了解决这个问题,我们引入了Chatbot Arena,一个基于人类偏好评估LLMs的开放平台。我们的方法采用成对比较方法,并通过众包从不同的用户群体中获取输入。该平台已经运行了几个月,累计收集了超过240K的投票。本文描述了该平台,并分析了目前我们所收集的数据,并解释了我们正在使用的有效和准确的评估和模型排名的统计方法。我们确认众包问题充分多样化和有区分力,并且众包人类投票与专家评分者的意见高度一致。这些分析共同为Chatbot Arena的可信度奠定了坚实的基础。由于其独特的价值和开放性,Chatbot Arena已成为LLM领域中最受参考的排行榜之一,并成为了行业标准。我们承诺公开我们的数据和代码,以确保该平台是开源的、易于获取的。

核心方法

- Chatbot Arena平台:集成了众包的方法,通过匿名的随机化对决来收集模型性能评估数据。

- 强大的统计方法:使用Bradley-Terry模型的统计模型到Vovk & Wang提出的E-值等多种强大的统计技术。

- 有效的取样算法:特别设计的取样算法,选择模型对进行排名,同时保留统计的有效性。

- 评估模型的排名:使用经典的Bradley-Terry模型估计模型的概率赢得胜利。

- 异常用户检测:初步步骤是用来识别出异常IP地址,在线对比新用户的评分与历史分布。

实验说明

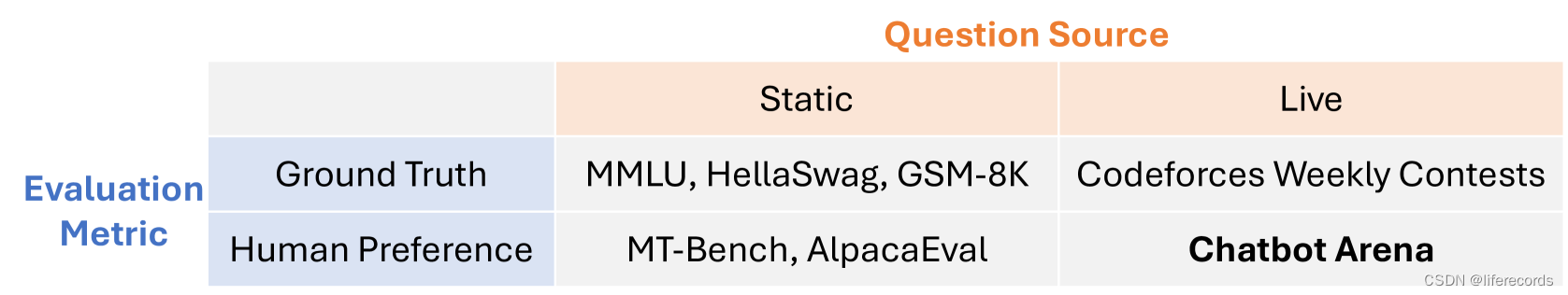

在实验中,通过DynaBench强调了静态基准测试的风险,并展示了如何使用人在回路等方法来创建实时基准测试。Chatbot Arena在这类测试中采用一个大规模用户层面的实现。

- 用户/模型交互:使用众包方法从用户那里获取模型评价反馈。

- 决策对比:用户在两个模型答案之间进行投票。

- 数据统计:自2023年4月收集数据以来,截止到2024年1月,收到了约240K次投票,覆盖超过50种模型和100多种语言。

结论

Chatbot Arena为LLMs提供了一个能够准确反映现实世界用例、基于用户偏好的开放而实时的评估平台。用户生成的问题具有足够的多样性,足以覆盖广泛的LLMs用例,并足以区分不同的模型。此外,我们所确认的众包投票与专家评估的高度一致性为我们的平台提供了强有力的支持。由于其独特的价值和开放性,Chatbot Arena已成为LLM领域中最重要的基准测试平台之一。