数据挖掘2.3——数据预处理 知识点整理

- 1.数据质量

- 2.数据预处理方法

- 2.1 数据清洗

- 2.2 数据集成

- 1. 模式集成

- 2. 实体识别问题

- 3. 数据冲突检测

- 2.3数据规约

- 1.降维

- 2.降数据

- 3.数据压缩

- 2.4数据转换和离散化

- 3.数据特征构造

- 完善

- 数据挖掘 2.3 —— 数据预处理

- 1. 数据质量

- 2. 数据预处理方法

- 2.1 数据清洗

- 2.2 数据集成

- 2.2.1 模式集成

- 2.2.2 实体识别问题

- 2.2.3 数据冲突检测

- 2.3 数据规约

- 2.3.1 降维

- 2.3.2 降采样

- 2.3.3 数据压缩

- 2.4 数据转换和离散化

- 3. 数据特征构造

1.数据质量

2.数据预处理方法

- 数据清理

- 填写缺失值, 平滑噪声数据, 识别或删除离群, 并解决不一致问题

- 数据集成

- 整合多个数据库, 多维数据集或文件

- 数据缩减

- 降维

- Numerosity reduction

- 数据压缩

- 数据转换和数据离散化

- 正常化

- 生成概念层次结构

2.1 数据清洗

- 脏数据

- 不完整的: 缺少属性值, 缺乏某些属性值, 或只包含总数据

- 忽略元组、手动填写、自动填写

- 含嘈杂的噪音, 错误或离群

- 例如, 工资= -10 (错误)

- 处理:盒装图检测并删除离群点

- 不一致的代码或不符的名称

- 年龄= “42” 生日=“03/07/1997”

- 曾经评级 “1,2,3” , 现在评级 “A, B, C”

- 计算推理替换、全局替换

2.2 数据集成

将来自多个数据源的数据组合成一个连贯的数据源

1. 模式集成

2. 实体识别问题

3. 数据冲突检测

2.3数据规约

原因

由于数据仓库可以存储TB的数据, 因此在一个完整的数据集上运行时, 复杂的数据分析可能需要一个很长的时间

1.降维

原因

①随着维数的增加, 数据变得越来越稀疏

②子空间的可能的组合将成倍增长

③需要学习的参数越多,模型越复杂,需要更多的训练集,越容易欠拟合

需要降维的场景

- 参数据稀疏, 维度高

- 高维数据采用基于规则的分类方法

- 采用复杂模型, 但是训练集数目较少

- 需要可视化

方法

- PCA主成分分析法

2.降数据

- 方法

抽样法

抽样类型

- 简单随机抽样(Simple Random Sampling)

- 相等的概率选择

- 不放回抽样(Sampling without replacement)

- 一旦对象被选中, 则将其删除

- 有放回抽样(Sampling with replacement)

- 选择对象不会被删除

- 分层抽样

- 每组抽相同个数

- 用于偏斜数据

3.数据压缩

2.4数据转换和离散化

函数映射,给定的属性值更换了一个新的表示方法, 每个旧值与新的值可以被识别。

方法

- 规范化: 按比例缩放到一个具体区间

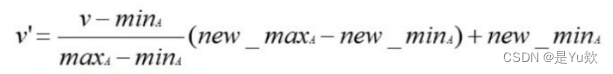

- 最小-最大规范化

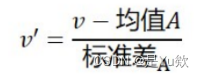

- Z-得分正常化

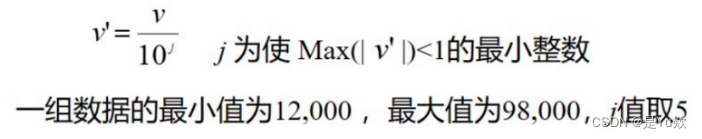

- 小数定标规范化

移动属性A的小数点位置(移动位数依赖于属性A的最大值)

- 离散化

原因:部分挖掘算法仅适用于离散数据

方法:

①非监督离散

等宽法、等频法、聚类

3.数据特征构造

完善

数据挖掘 2.3 —— 数据预处理

数据预处理是数据挖掘中至关重要的一个步骤,它涉及到数据的清洗、集成、规约、转换以及特征构造等任务。以下是有关数据预处理的知识点整理:

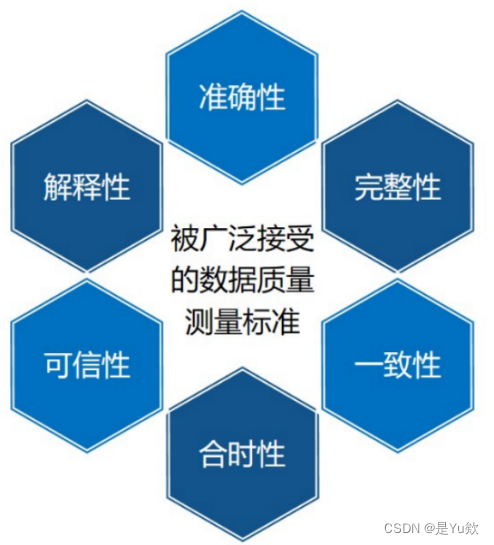

1. 数据质量

数据质量是指数据的准确性、完整性、一致性、可信度和及时性等属性。数据质量问题可能包括缺失值、异常值、不一致值等,这些问题需要在数据预处理阶段进行解决。

2. 数据预处理方法

2.1 数据清洗

数据清洗是指检测和纠正数据中的错误、不一致性和缺失值等问题。常见的数据清洗方法包括替换缺失值、删除异常值、解决数据不一致性等。

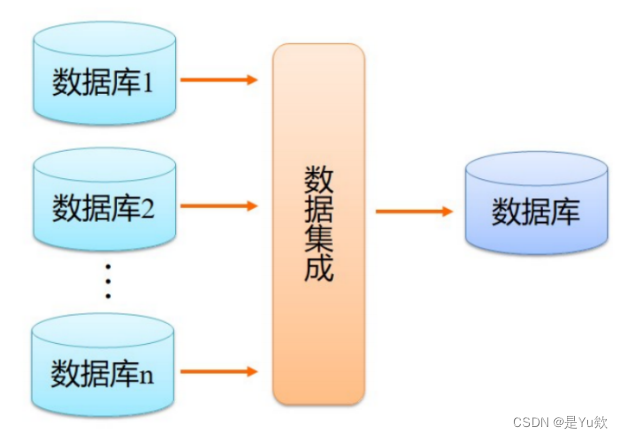

2.2 数据集成

数据集成涉及将来自不同数据源的数据集合并成一个一致的数据集。在数据集成过程中,可能会涉及以下问题:

2.2.1 模式集成

不同数据源的数据可能有不同的数据模式,需要将它们合并成一致的模式。例如,日期格式的不同、列名的不同等。

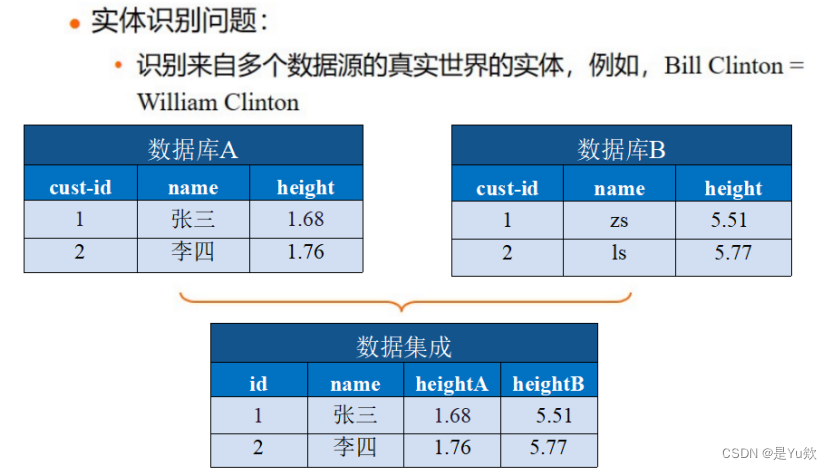

2.2.2 实体识别问题

在数据集成中,需要识别数据中的实体,以确保它们表示相同的实体。例如,一个人的名字在不同数据源中可能用不同的方式表示。

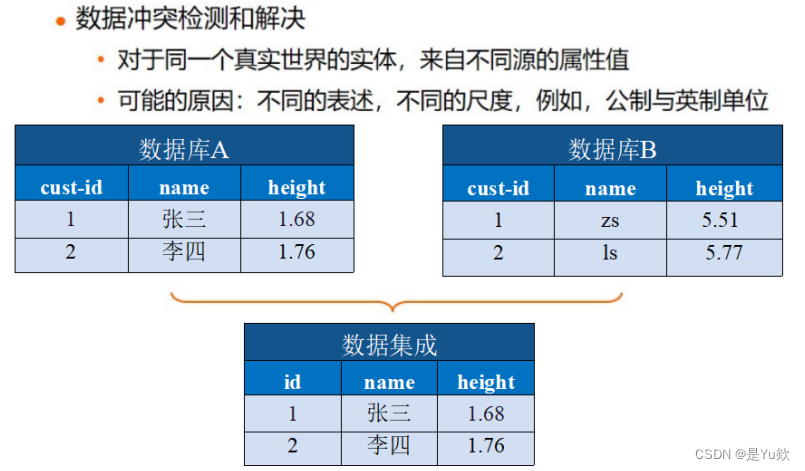

2.2.3 数据冲突检测

数据集成可能会导致数据冲突,例如,同一实体的不同数据源可能有不同的数值。数据冲突检测和解决是数据集成的关键任务。

2.3 数据规约

数据规约是指减少数据量,以降低计算和存储开销。数据规约可以通过降维、降采样和数据压缩等方法来实现。

2.3.1 降维

降维是指减少数据的维度,以保留重要信息并减少冗余。常见的降维技术包括主成分分析(PCA)和奇异值分解(SVD)等。

2.3.2 降采样

降采样是指减少数据样本数量,以降低计算成本。例如,随机抽样或根据特定条件选择子集数据。

2.3.3 数据压缩

数据压缩是通过压缩算法来减小数据的存储空间。数据压缩可以用于大规模数据的存储和传输。

2.4 数据转换和离散化

数据转换和离散化是将数据从一个形式转换为另一个形式的过程。它可以包括归一化、标准化、对数变换等操作,以使数据适合特定的分析或模型。

3. 数据特征构造

数据特征构造是指创建新的特征或属性,以帮助提高数据挖掘模型的性能。特征构造可以涉及从原始数据中提取有意义的信息、创建交叉特征、进行特征选择等。

数据预处理是数据挖掘过程中的关键环节,它直接影响到模型的性能和分析结果。合理的数据预处理方法和技术可以帮助提高模型的准确性和可解释性。